Hash

觉得什么笔记软件都不好用,恰好疲于选择博客主题,因此使用 mdBook 记下一点东西。

才疏学浅,应该有很多不对的地方,欢迎和我一起讨论 ^^

关于我

网名“一粒”、常用提交 ID qaqland,是 Alpine Linux && deepin Linux 桌面用户。

我的计算机知识和代码水平比较肤浅:

- 会一点 C 但是既没编译过内核也没搞过驱动

- 会一点 Rust 不过日常看不懂生命周期

- 会一点 Linux 但总是听不懂群友在讨论什么

说要做很多项目,但是至今 3000 行以上的没写出来几个。目前还在关注的有:

- Wless:定位上高于 cage 约等于 dwl 的窗管,基于 wlroots

- BuShi:目标是取代 cgit 成为 gitweb 的首选,基于 Rust 和 SQLite

以上两个项目进行了初步尝试,位于 30% 阶段。

Alpine Linux 软件打包

2024 年 1 月 14 日

软件仓库的总部叫 aports,目前是官方 GitLab 实例上的一个超大 repository,

所有与官方有关的软件包提交修改都基于仓库的流水线,有什么问题可以查阅 Wiki,

也可以前往 oftc.net 上的 #alpine-devel 频道(IRC)寻求帮助。

$ git clone --depth=1 ...

据观察基于邮箱的协作好像不太能用,只能注册 GitLab 使用。 找到官方的仓库 fork 到自己名下(就像 GitHub 那样),接下来的大致流程:

- 绑定密钥、设置用户名与用户邮箱

- 克隆自己的 fork 到本地,耐心等待

- 为自己需要修改的地方创建分支

- 修改(测试)并提交,推送新分支到仓库

- 在网页里自己的仓库页面提交合并请求

Alpine Linux 软件包的配置文件 APKBUILD 与 Arch Linux 的 PKGBUILD 非常相似, 可以偷偷去他们的网站学习打包经验, 但是不要抄袭——发行版不同、工具链不通用、分包策略也不同。 同时也非常推荐 Fedora 家的包,他们相比 Arch 更加严格规范,易于参考。

网址

- 包管理器使用 https://wiki.alpinelinux.org/wiki/Alpine_Package_Keeper

- 新建软件包 https://wiki.alpinelinux.org/wiki/Creating_an_Alpine_package

- 配置文件说明 https://wiki.alpinelinux.org/wiki/APKBUILD_Reference

- 打包相关工具 https://wiki.alpinelinux.org/wiki/Abuild_and_Helpers

- 与 aports 仓库相关的 aports/README.md

- 代码与提交格式要求 CODINGSTYLE.md COMMITSTYLE.md

- Arch Linux 的包 https://archlinux.org/packages/

- Fedora 的包 http://src.fedoraproject.org/

FAQ

由于 musl 引起的编译错误如何解决?

应该都有人遇到过,aports 搜一搜自己也做个补丁

如何知道软件需要的依赖?

- 构建依赖:

abuild rootbld一个一个添加 dev 包测试 - 运行依赖:打包时会自动识别大部分动态库,手动加上额外的运行时依赖

编译需要的 gcc 是依赖吗?

build-base 已有,不需要写,apk info -r build-base 查看类似基础组件

网络问题拉不下来构建需要的源码

使用 http 代理,例如:https_proxy=http://localhost:7890/ abuild checksum

软件包依赖另外一个自己打的本地包

abuild rootbld 时添加 ~/packages/testing/ 到 ~/aports/testing/.rootbld-repositories

怎么知道安装包里包含什么文件

新版 tar 会自动识别压缩格式,执行tar -vtf file.apk获得文件列表

每次下载软件包耗时很久

- 开启

setup-apkcache $ mirror=http://mirrors.tuna.tsinghua.edu.cn/alpine abuild rootbld

最后如果有其他问题可以联系我

C 跨行字符串

2025-12-13

实用小技巧之跨行字符串(字面量)

#define SQL(...) #__VA_ARGS__

const char *foo = SQL(

HELLO WORLD

\n // 111

/* 222 */

next line 111?

""

);

// equal

const char *foo = "HELLO WORLD \n next line 111? \"\"";

细节拆解:

- Stringizing in C involves more than putting double-quote characters around the fragment. 不仅仅会在字符串两端加上双引号

- The preprocessor backslash-escapes the quotes surrounding embedded string constants, and all backslashes within string and character constants. 而且会转义字符串中适当位置的双引号

- Any sequence of whitespace in the middle of the text is converted to a single space in the stringized result. 像 Markdown 一样压缩所有的空白字符到一个空格

- Comments are replaced by whitespace 忽略注释(因为注释会在预处理器之前被处理)

上下文

为了给 bushi-index 找可以学习的素材,在 GitHub 搜索 SQLite3 项目找到了这里。 对 SQL 来说(吃掉换行符)转为一行的行为,比转成多行然后前面带缩进好。不错!

参考链接

- https://github.com/yonasBSD/litterbox/blob/1.9/database.h#L41

- https://github.com/yonasBSD/litterbox/blob/1.9/database.h#L325

- https://gcc.gnu.org/onlinedocs/cpp/Stringizing.html

CUnit Cheet Sheet

用 C 写代码是一件简单又困难的事,尤其是从 0 开始搓,补测试可以减少心理上的恐惧。

框架选择

C 语言生态很权威,只需要去 Linux 发行版的源中找到一个能顺利安装的库就行。 本文随机选到了 CUnit,需要注意两点:

- GPL-2.0-or-later 协议

- 10 年未更新了

添加依赖

如果是 Alpine Linux,可以看到系统包管理安装后已经有了 .pc 文件

$ pkgconf --cflags --libs cunit

-lcunit

此时只需要在 meson.build 中增加一行即可

--- a/meson.build

+++ b/meson.build

@@ -12,4 +12,5 @@ project(

dependencies = [

dependency('sqlite3'),

dependency('libgit2'),

+ dependency('cunit'),

]

然后新开一个 target 补上一条 test(target)。

测试层级

与一般的测试框架一样,具有层级结构

Test Registry

├── Suite '1'

│ ├── Test '1-1'

│ ├── ...

│ └── Test '1-M'

├── ...

└── Suite 'N'

├── Test 'N-1'

├── ...

└── Test 'N-M'

因此最基础的测试可以这样写:

- 初始化测试表

CU_initialize_registry(void) - 新建测试套件

CU_add_suite() - 添加测试用例

CU_add_test() - 终端运行测试

CU_console_run_tests(void) - 清理测试表等

CU_cleanup_registry(void)

以上所有内容发生在一个单文件内,多文件部分暂无测试,等待后续补充。

生命周期

对于测试表,需要在一开始初始化并在最后清理(见上),这是全局作用域范围。

对于测试套件,可以在新建时传入 NULL 或两个函数指针管理生命周期, 分别在测试套件运行的前后各调用一次。

CU_pSuite CU_add_suite(const char* strName, // UNIQUE

CU_InitializeFunc pInit, // int (*)(void *)

CU_CleanupFunc pClean); // int (*)(void *)

错误处理

CUnit 的函数基本不需要错误处理,内存不足几乎不可能(只在测试框架中)发生。

内存不足返回的 NULL 触发 SIGSEV 是有预期而且可以接受的,程序应当崩溃。 例如 GLib 有说:

unless otherwise specified, any allocation failure will result in the application being terminated.

辅助函数

自己写的测试用例需要使用库提供的辅助函数,然后添加到测试套件。

#define CU_ADD_TEST(suite, test) (CU_add_test(suite, #test, (CU_TestFunc)test))

CU_pTest CU_add_test(CU_pSuite pSuite,

const char* strName, // UNIQUE

CU_TestFunc pTestFunc); // void (*)(void)

辅助函数以 CU_ 为前缀,和常见的 assert.h 差不多,只不过更丰富一点

CU_{ASSERT,TEST}

CU_ASSERT_{TRUE,FALSE}

CU_ASSERT_{,NOT_}EQUAL

CU_ASSERT_PTR_{,NOT_}EQUAL

CU_ASSERT_PTR_{,NOT_}NULL

CU_ASSERT_STRING_{,NOT_}EQUAL

CU_ASSERT_NSTRING_{,NOT_}EQUAL

CU_ASSERT_DOUBLE_{,NOT_}EQUAL

CU_{PASS,FAIL}

最后一行的 PASS 和 FAIL 小 helper 不做实际判断,仅输出 message 供用户观察。

大部分辅助函数还有带 _FATAL 后缀的版本,失败会立即崩溃退出,不推荐使用,

猜测可以用来刻意 coredump 然后 GDB 介入。

测单文件

写 C 怎么可能不写宏呢?为了避免拆多文件,把原本的 main 入口修饰一下:

#ifdef RUN_TEST

#define test_main main

#else

#define true_main main

#endif

参考阅读

- https://cunit.sourceforge.net/

- https://cunit.sourceforge.net/doc/index.html

- https://stackoverflow.com/questions/7940279/should-we-check-if-memory-allocations-fail

JuDou 句读

2025 年 5 月 14 日 记录一下项目想法

概述

JuDou 是一个基于 LSP 的代码审阅辅助工具,通过在本地建立预缓存,实现在网页端的语义高亮和引用跳转。

- 服务端:资源消耗极低

- 客户端:无需环境配置

- 流水线:自动集成构建

名称

“常买旧书的人,有时会遇到一部书,开首加过句读,夹些破句,中途却停了笔:他点不下去了。”

技术栈

- Golang

- Vue

- Json-RPC 2.0

- Json

盈利

前期贴皮广告,中期 SAAS,后期私有化部署。

直接竞争对手为 GitHub 和 Sourcegraph,潜在包括各类 LLM 分析工具。

参考

- https://github.com/netmute/ctags-lsp

- https://github.com/sourcegraph/jsonrpc2

- https://microsoft.github.io/language-server-protocol/

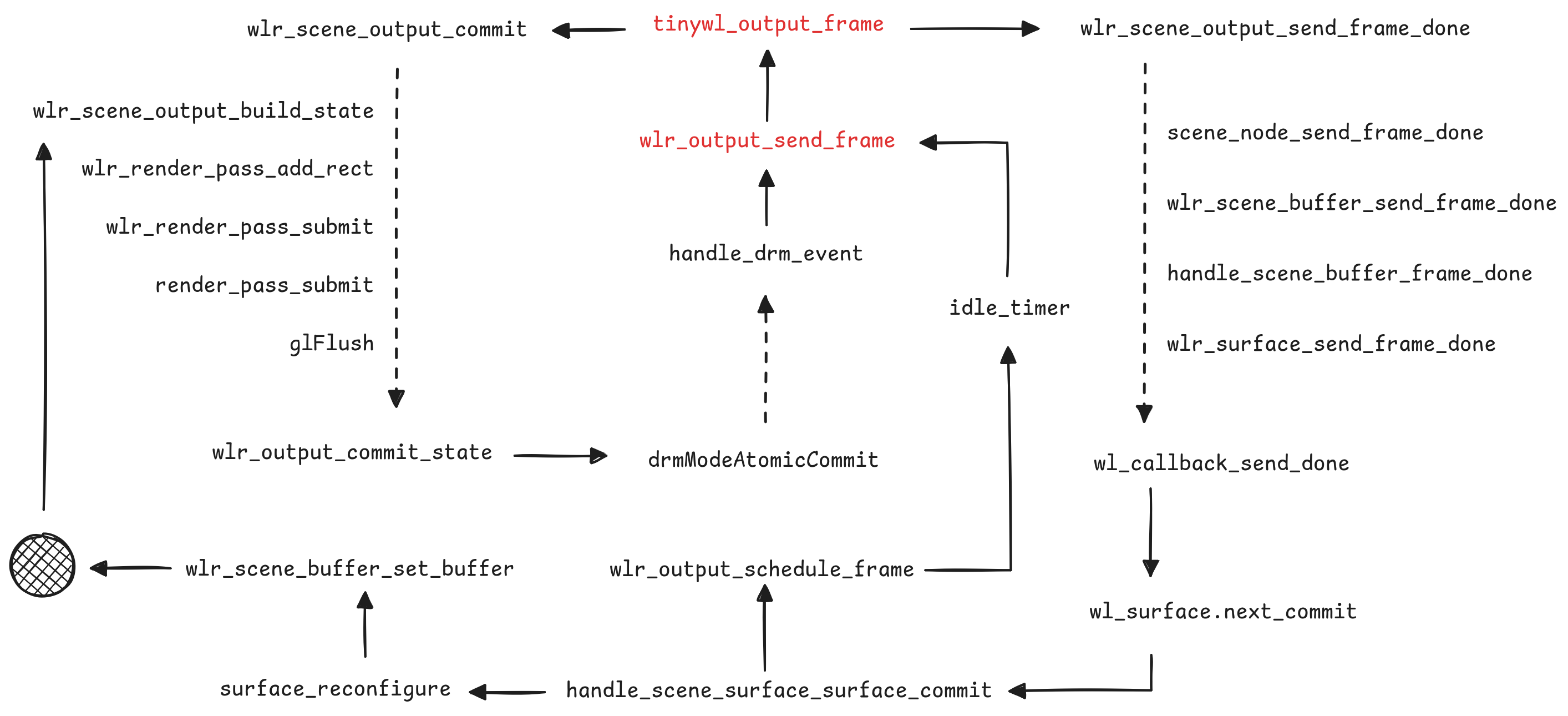

TinyWL’s Frame

一直想学习 wlroots 项目中的 scene 抽象,于是先从 output 的 frame 回调开始。 内容基于 0.19.0 版本的 wlroots 源码。

Request a notification when it is a good time to start drawing a new frame, by creating a frame callback…

协议 wl_surface:request:frame 确保客户端绘制与显示器同步。

Tinywl 中 output_frame 函数绑定在 wlr_output 的 frame 信号上,

触发主要与后端有关,受到显示器的 page-flip 等帧率限制。

在合适的时间,合成器主动触发请求 frame 中的 wl_callback 回调 done,

提醒客户端可以准备下一帧。

The frame request will take effect on the next

wl_surface.commit.The

callback_datapassed in the callback is the current time…

发送一个不知何时开始的毫秒时间给客户端,想不出来除了时间还有什么其他影响。

在函数回复 done 之前的 wlr_scene_output_commit 在处理当前帧的数据状态,

wlr_output_commit_state 函数是我们在初始化 wlr_output 的 mode 时见过的老朋友。

经过接口 wlr_output_impl 和 wlr_drm_interface 的分发,

现代硬件很有可能走到了 drmModeAtomicCommit 的底层调用,

这个函数从内核绕了一圈,又会触发后端的 drm_event 产生一次 frame 事件。

TinyWL 对 wl_surface:request:commit 的监听约等于空,

可以认为是 scene 也监听了这个信号并在背后自动完成相关工作,

如函数 handle_scene_surface_surface_commit。

wlr_output_schedule_frame 和 wlr_output_send_frame 关系紧密,

一个偏业务另一个偏资源。大部分情况下应用窗口随显示器刷新不断收发:

- surface.commit

- request frame

- waiting about 1/60s

- callback.done

- surface.commit

但是应用窗口的 commit 可能不会触发 backend 的实际 commit 造成没有 frame 回调, 因此加入 schedule 以期在闲置时为应用程序有序刷新出 done。

对于 Scene 场景累积状态,以 wlr_scene_node_set_position 函数为例流程如下,

核心逻辑包含在 scene_node_bounds 和 scene_update_region 中:

步骤 1: 更新节点位置 wlr_scene_node_set_position

node->x = 100

node->y = 200

↓

步骤 2: 调用 scene_node_update

↓

步骤 3: 计算全局坐标 wlr_scene_node_coords

x = 100, y = 200 (假设无父节点)

↓

步骤 4: 调用 scene_node_bounds(node, 100, 200, &update_region)

update_region = rect(100, 200, width, height)

↓

步骤 5: 调用 scene_update_region(scene, &update_region)

→ 遍历 rect(100, 200, width, height) 内的所有节点

→ 更新每个节点的 node->visible 可见性

→ 触发 enter/leave 事件 update_node_update_outputs

↓

步骤 6: 完成更新,等待 wlr_scene_output_build_state

后续:发现 LLM 很好用,只要问题明确有 80% 的正确率,我要当投降派了。

Ref

- https://gitlab.freedesktop.org/wlroots/wlroots/-/blob/0.19.0/tinywl/tinywl.c

- https://wayland.app/protocols/wayland#wl_surface:request:frame

- https://wayland.app/protocols/wayland#wl_surface:request:commit

进程与环境变量

2025 年 5 月 18 日 在想办法用环境变量做程序的配置系统

数据结构

理论上讲应该采用 HashMap 的数据格式保存,以实现 O(1) 的访问速度。

#include <unistd.h>

char **__environ = 0;

weak_alias(__environ, ___environ);

weak_alias(__environ, _environ);

weak_alias(__environ, environ);

// https://git.musl-libc.org/cgit/musl/tree/src/env/__environ.c

但实际使用形如 KEY=VALUE 的字符串数组。

系统调用

对环境变量的读和写均发生在用户态:

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

char *getenv(const char *name)

{

size_t l = __strchrnul(name, '=') - name;

if (l && !name[l] && __environ)

for (char **e = __environ; *e; e++)

if (!strncmp(name, *e, l) && l[*e] == '=')

return *e + l+1;

return 0;

}

// https://git.musl-libc.org/cgit/musl/tree/src/env/getenv.c

仅初始化与系统调用有关:

#include <unistd.h>

#include "syscall.h"

int execve(const char *path, char *const argv[], char *const envp[])

{

/* do we need to use environ if envp is null? */

return syscall(SYS_execve, path, argv, envp);

}

// https://git.musl-libc.org/cgit/musl/tree/src/process/execve.c

Bash

在 Bash 中很坏,“环境变量”只是普通变量的一个属性,一般用 export 关键字标识

#define att_exported 0x0000001 /* export to environment */

...

#define att_local 0x0000020 /* variable is local to a function */

// bash/variables.h

/* An array which is passed to commands as their environment. It is

manufactured from the union of the initial environment and the

shell variables that are marked for export. */

char **export_env = (char **)NULL;

// bash/variables.c

所以会出现以下情况,环境变量随变量修改而改变:

export foo=bar

foo=barbar

sh -c 'echo $foo'

# output: barbar

其它对环境变量的构建和修改与普通函数无异

static inline char *

mk_env_string (name, value, attributes)

const char *name, *value;

int attributes;

{

...

{

p = (char *)xmalloc (2 + name_len + value_len);

memcpy (p, name, name_len);

q = p + name_len;

}

q[0] = '=';

memcpy (q + 1, value, value_len + 1);

}

// bash/variables.c

int

shell_execve (command, args, env)

char *command;

char **args, **env;

{

...

execve (command, args, env);

}

// bash/execute_cmd.c

Git Summary

2025-11-12

Git介绍及初始化

- https://git-scm.com/

- https://git-scm.com/book/zh/v2

- https://git-scm.com/docs

- https://github.com/git-guides

- https://lore.kernel.org/git/

- https://training.github.com/downloads/zh_CN/github-git-cheat-sheet/

- https://planet.deepin.org/deepin-2022-01-21-git-from-the-bottom-up-git/

Git是一个分布式(Version Control Software,CVS)版本控制工具,事实上的业界标准。

重要提示:Git一定要和SSH搭配用!

生成SSH密钥

# 进入用户的 ssh 目录

$ cd .ssh/

# 本地创建密钥对

$ ssh-keygen

Generating public/private ed25519 key pair.

Enter file in which to save the key (~/.ssh/id_ed25519): key-name # 输入名字

Enter passphrase for "key-name" (empty for no passphrase): # 留空

Enter same passphrase again: # 留空

Your identification has been saved in key-name

Your public key has been saved in key-name.pub

The key fingerprint is:

SHA256:cUcRFTTxmKf1hXklQBBrfE8Muk8+AdwSwi9sM7Gc4KA anguoli@anguoli-PC

The key's randomart image is:

+--[ED25519 256]--+

| .. ++B*Bo.|

| . . o+ * o O.|

| . o +.=X + B *|

| E . X+.* o =o|

| .S+. o o .|

| + . |

| + |

| . |

| |

+----[SHA256]-----+

# 生成了两个文件

$ ls -l key-*

-r-------- 1 anguoli anguoli 411 11月10日 14:06 key-name

-rw-r--r-- 1 anguoli anguoli 100 11月10日 14:06 key-name.pub

# 公钥可以随意上传、分发

$ cat key-name.pub

ssh-ed25519 AAAAC3NzaC1lZDI1NTE5AAAAIGKl7MdmTVHQPbjJ2jKDzcMlLZre/eaEgUZaC9HcODR1 anguoli@anguoli-PC

# 私钥保存在本地,注意0400权限

$ cat key-name

-----BEGIN OPENSSH PRIVATE KEY-----

XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

LZre/eaEgUZaC9HcODR1AAAAEmFuZ3VvbGlAYW5ndW9saS1QQwECAw==

-----END OPENSSH PRIVATE KEY-----

创建SSH配置

# ~/.ssh/config

Host gitlabwh.uniontech.com

Hostname gitlabwh.uniontech.com

User git

IdentityFile ~/.ssh/gerrit

Host gerrit.uniontech.com

Hostname gerrit.uniontech.com

Port 29418

User git

IdentityFile ~/.ssh/gerrit

Host github.com

Hostname ssh.github.com

User git

Port 443

ProxyCommand nc -v -x 127.0.0.1:7897 %h %p

IdentityFile ~/.ssh/github

Git使用到的SSH与普通用户字段基本相同

- Host 别名/配置名,对SSH有用

- Hostname 真实主机地址,IP或者域名

- IdentityFile 私钥绝对路径

配置代理推荐使用netcat-openbsd包提供的nc命令,可以加速走SSH的全部Git操作

- ProxyCommand 代理

-4/-6指定仅IPv4或IPv6-X [4|5|connect]SOCKS v.4, SOCKS v.5 and HTTPS proxy,默认5-x address:port%hHostname,%pPort

测试Git&SSH

ssh -T git@Host

Disable pseudo-terminal allocation. 禁用伪终端分配,不会交互式Shell会话

$ ssh -T [email protected]

Connection to ssh.github.com 443 port [tcp/https] succeeded!

Hi qaqland! You've successfully authenticated, but GitHub does not provide shell access.

$ ssh -T gitlabwh.uniontech.com

Welcome to GitLab, @ut006245!

$ ssh -T gerrit.uniontech.com

[email protected]: Permission denied (publickey).

Git配置

# 默认分支

git config --global init.defaultBranch main

# 用户和邮箱

git config --global user.name "qaqland"

git config --global user.email "[email protected]"

# 编辑器

git config --global core.editor "vim"

# 快捷别名

git config --global alias.ss status

git config --global alias.can "commit --amend --no-edit --date=now"

这些配置都会写入文件~/.gitconfig

[user]

name = qaqland

email = [email protected]

[init]

defaultBranch = main

# 配置http/https需要的代理

[http "https://github.com/"]

proxy = socks5h://127.0.0.1:7897

[alias]

can = commit --amend --no-edit --date=now

ss = status

[core]

editor = vim

Git的基本数据结构

- 标准Git仓库的版本数据保存在仓库的

.git路径中 - Git命令支持的环境变量

GIT_DIR应当指向仓库的.git路径 - 裸仓库(常见于服务端)只有

.git路径和内容

Objects

Git的大部分数据都以Object的形式保存在.git/objects路径下,

每个Object都有自己的UUID也叫做Oid,以SHA1或SHA256格式存在,同一仓库不能混合使用,

大部分操作都可以尝试Oid的前缀缩写。

可以通过命令git cat-file -t OID检查类型,常见Object种类有:

- CommitObject 提交

- TreeObject 目录

- BlobObject 内容

$ git init test-backend

已初始化空的 Git 仓库于 /tmp/test-backend/.git/

$ cd test-backend/

$ echo 1 > 1

$ echo 2 > 2

$ git add .

$ git commit -m test

[main(根提交) 084ca84] test

2 files changed, 2 insertions(+)

create mode 100644 1

create mode 100644 2

$ tree .git/objects/

.git/objects/

├── 08

│ └── 4ca8409b7102d53b1b279627cb41ccba5bac98 # commit

├── 0c

│ └── fbf08886fca9a91cb753ec8734c84fcbe52c9f # blob

├── d0

│ └── 0491fd7e5bb6fa28c517a0bb32b8b506539d4d # blob

├── de

│ └── 0ea882503cdd9c984c0a43238014569a123cac # tree

├── info

└── pack

7 directories, 4 files

Loose & Packed

Git有两种Objects的保存后端,分别是Loose松散后端和Packed紧实后端。

如上文所示以Oid的前2位为前缀创建目录树的行为就是Loose松散后端。 松散后端由本地提交产生,其中对象仅以zlib算法压缩,占用空间较大,但写入速度快。

本地执行git gc会repack这些对象到紧实后端

$ git gc

枚举对象中: 4, 完成.

对象计数中: 100% (4/4), 完成.

使用 8 个线程进行压缩

压缩对象中: 100% (2/2), 完成.

写入对象中: 100% (4/4), 完成.

总共 4(差异 0),复用 0(差异 0),包复用 0(来自 0 个包)

$ tree .git/objects/

.git/objects/

├── info

│ ├── commit-graph

│ └── packs

└── pack

├── pack-5468214027a9484a198c7f3c5a6df15f12f48d9d.idx

├── pack-5468214027a9484a198c7f3c5a6df15f12f48d9d.pack

└── pack-5468214027a9484a198c7f3c5a6df15f12f48d9d.rev

3 directories, 5 files

为了节省带宽、减小请求,通常在网络交互时也会repack(传输的部分)

# 文件协议,也算传输,有repack

git clone file:///tmp/test-backend/ test-clone-file

# 路径克隆,直接复制,没有repack

git clone /tmp/test-backend/ test-clone-path

先看Loose,我们写个小脚本查看实际保存的Object

#!/usr/bin/env python3

import zlib, sys

data = open(sys.argv[1], "rb").read() if len(sys.argv) > 1 else sys.stdin.buffer.read()

result = zlib.decompress(data)

sys.stdout.buffer.write(result)

CommitObject

提交Commit指向自己的历史来源,有0个、1个、2个或者更多个Parent Commit。 不同的数量表示了这次提交的不同种类,是root节点还是fast-forward这种单线链表, 或者是合并分支的Merge节点。超过2的情况不多见,是特殊的合并节点,比如内核里有:

Merge branches ‘arch-alpha’, ‘arch-arm’, ‘arch-arm64’, ‘arch-avr32’, … · torvalds/linux@9b25d60

https://github.com/torvalds/linux/commit/9b25d604182169a08b206306b312d2df26b5f502

A commit object may have any number of parents. With exactly one parent, it is an ordinary commit. Having more than one parent makes the commit a merge between several lines of history. Initial (root) commits have no parents.

当然像提交信息、提交人、提交时间、以及Committer与Author之间的区别这里不再赘述。 Commit还保存了提交时的文件(树)快照,指向当前Commit相随的Tree。

- TreeOid

- Parents’ CommitOid

- Author

- Committer

- Commit Message

这就是一个Commit对象包含的全部,当一个普通线性提交发生时, Git会扫描当前WorkTree生成TreeOid,底层保存的数据中并不关心此次提交的修改。

$ git cat-file -p 91520a2890c9cd9e99bf6cf0148811c33ffe5a3b

tree f93e3a1a1525fb5b91020da86e44810c87a2d7bc

author qaqland <[email protected]> 1762827659 +0800

committer qaqland <[email protected]> 1762827659 +0800

add readme

$ git cat-file -t 91520a2890c9cd9e99bf6cf0148811c33ffe5a3b

commit

$ git cat-file -s 91520a2890c9cd9e99bf6cf0148811c33ffe5a3b

155

$ git cat-file commit 91520a2890c9cd9e99bf6cf0148811c33ffe5a3b | wc -c

155

以这次提交为例,把原始文件zlib解压后16进制打印输出如下

$ ./zlib-cat.py .git/objects/91/520a2890c9cd9e99bf6cf0148811c33ffe5a3b | xxd

00000000: 636f 6d6d 6974 2031 3535 0074 7265 6520 commit 155.tree

00000010: 6639 3365 3361 3161 3135 3235 6662 3562 f93e3a1a1525fb5b

00000020: 3931 3032 3064 6138 3665 3434 3831 3063 91020da86e44810c

00000030: 3837 6132 6437 6263 0a61 7574 686f 7220 87a2d7bc.author

00000040: 7161 716c 616e 6420 3c71 6171 4071 6171 qaqland <qaq@qaq

00000050: 2e6c 616e 643e 2031 3736 3238 3237 3635 .land> 176282765

00000060: 3920 2b30 3830 300a 636f 6d6d 6974 7465 9 +0800.committe

00000070: 7220 7161 716c 616e 6420 3c71 6171 4071 r qaqland <qaq@q

00000080: 6171 2e6c 616e 643e 2031 3736 3238 3237 aq.land> 1762827

00000090: 3635 3920 2b30 3830 300a 0a61 6464 2072 659 +0800..add r

000000a0: 6561 646d 650a eadme.

起始commit和155表示类型和大小(不包括头部),和前文的cat-file -t|-s对应

| HEX | Description |

|---|---|

00 | Null character |

20 | Space |

0a | Line Feed |

30 | Zero |

TreeObject

$ git cat-file -p f93e3a1a1525fb5b91020da86e44810c87a2d7bc

100644 blob e69de29bb2d1d6434b8b29ae775ad8c2e48c5391 README.md

$ git cat-file -t f93e3a1a1525fb5b91020da86e44810c87a2d7bc

tree

$ git cat-file -s f93e3a1a1525fb5b91020da86e44810c87a2d7bc

37

$ git cat-file tree f93e3a1a1525fb5b91020da86e44810c87a2d7bc | wc -c

37

$ git cat-file tree f93e3a1a1525fb5b91020da86e44810c87a2d7bc | xxd

00000000: 3130 3036 3434 2052 4541 444d 452e 6d64 100644 README.md

00000010: 00e6 9de2 9bb2 d1d6 434b 8b29 ae77 5ad8 ........CK.).wZ.

00000020: c2e4 8c53 91

一个TreeObject保存任意数量的TreeObject和BlobObject,保存信息有子目录或文件的 权限(条目类型)、条目名称、条目Oid。

$ ./zlib-cat.py .git/objects/f9/3e3a1a1525fb5b91020da86e44810c87a2d7bc | xxd

00000000: 7472 6565 2033 3700 3130 3036 3434 2052 tree 37.100644 R

00000010: 4541 444d 452e 6d64 00e6 9de2 9bb2 d1d6 EADME.md........

00000020: 434b 8b29 ae77 5ad8 c2e4 8c53 91 CK.).wZ....S.

仓库的Oid长度是统一且固定的,如果采用SHA1就是40个十六进制字符,SHA256拓展到64个。

在TreeObject对象中,条目是按照路径排序的,TreeObject条目会在排序时默认带上尾随斜杠

The entries in a tree are ordered in the path order, which means that a directory entry is ordered by adding a slash to the end of it.

So a directory called “a” is ordered after a file called “a.c”, because “a/” sorts after “a.c”.

git/fsck.c at 6074a7d4ae6b658c18465f10bbbf144882d2d4b0 · git/git

$ git ls-tree 00a741484baadea211c493ebbf5fb00208f86493

100644 blob 85d4df20ce3cce7d9bf31f98ee2239683fdc776e .editorconfig

100644 blob 0493cf8daa1629bdba77e9bdde6106ff9783fc50 .gitattributes

040000 tree 1297f3467c63c4ff48a98fd2a24d747c68aa3f80 .githooks

040000 tree b79b5cc40348d01f293bd9cbf8483cc077459c38 .github

100644 blob 43fb11d16d0008c3314eeab288f49b6189d680dd .gitignore

100644 blob 70d4ae27a4b250d03eaded0509f86347e6192c42 .gitlab-ci.yml

040000 tree aefeddacabdf8150f47faf3aabd098c5c7c32440 .gitlab

100644 blob b7bf3d42eb30206489f669629bd95c8fcb2d2ee6 .mailmap

100644 blob 8d11373a95ba9d87c8a51193c37d5aa02e2dd301 CODINGSTYLE.md

100644 blob ab8c36d86bcf6eaaff348f1c24bf6594bdcabdfb COMMITSTYLE.md

100644 blob 27d11c0186c4e846c5d5f64af7121cadbb8d785f README.md

040000 tree 42aae92dacdae1a5d53531d23ddbac8aeabd13e8 community

040000 tree 0cc9f0ba0475a8302206e431ca51319ce21d6b54 main

040000 tree dcaedd687a45f21b59296a063787a5ee15385716 scripts

040000 tree 8f5eebf9181a091b171b123f6377108560f5ecdf testing

BlobObject

没有任何技巧和优化的:类型、大小、内容,不保存自己的名称

假如文件内容为Hello World\n:

# 文件末尾有换行

$ hexdump -C hello

00000000 48 65 6c 6c 6f 20 57 6f 72 6c 64 0a |Hello World.|

0000000c

# 文件长度为12

$ wc -c hello

12 hello

可以计算得到此时的sha1sum

# 类型 + 空格 + 长度 + NUL + 内容

$ printf "blob 12\0Hello World\n" | sha1sum

557db03de997c86a4a028e1ebd3a1ceb225be238 -

添加文件并提交后可以看到git给出的BlobOid与我们手动计算的相同

$ tree .git/objects/

.git/objects/

├── 11

│ └── 7c62a8c5e01758bd284126a6af69deab9dbbe2

├── 55

│ └── 7db03de997c86a4a028e1ebd3a1ceb225be238 <<< 这里

├── f7

│ └── a2bdf7b9df15cdbc88907855a2f55170839af8

├── info

└── pack

6 directories, 3 files

Reference

引用(Reference)类似C语言的指针,

分为直接引用(指向具体的Oid)和符号引用(指向其他引用)两种,

保存在.git/*HEAD、.git/packed-refs和.git/refs/路径下。

直接引用(Direct Reference)存储的是完整的Oid, 如果指向的提交被删除或修改,直接引用可能失效(成为悬空引用), 如果直接引用被删除,可能导致指向的一系列对象变为垃圾对象(分离状态)。 常见的直接引用有:

refs/heads/main分支refs/tags/v1.0标签refs/remotes/origin/main远程分支

符号引用(Symbolic Reference)本身不指向具体对象,而是指向另一个引用,相当于间接指针。

最常见的HEAD就是符号引用,指向当前分支(如refs/heads/main)

$ cat .git/HEAD

ref: refs/heads/main

$ cat .git/refs/heads/main

f7a2bdf7b9df15cdbc88907855a2f55170839af8

$ git log -1

commit f7a2bdf7b9df15cdbc88907855a2f55170839af8 (HEAD -> main)

Author: qaqland <[email protected]>

Date: Tue Nov 11 13:55:14 2025 +0800

hello

// HEAD @ ~ ^

Git的日常使用方法

老生常谈的“工作区”、“暂存区”、“版本库”三个概念,他们是为了确保提交的原子性(完整性)。 类比到Wayland:

- Git:

git commit操作是原子性的。 要么整个暂存区的内容全部成功提交,创建一个新的版本记录;要么失败,版本库保持原样。 永远不会看到一个“只提交了一半文件”的版本库状态。 - Wayland:缓冲区交换操作也是原子性的。 在垂直同步信号到来时,系统会瞬间将指向屏幕的指针从“前缓冲区”切换到“完成后缓冲区”。 用户永远不会看到一帧“画了一半”的图像。

这个“原子性”确保了从一个状态(上次提交的版本/上一帧画面)平滑过渡到下一个状态(新的提交/新的一帧画面)。

git-log

# 显示提交图

$ git log --oneline --graph --all

# 显示提交代码

$ git log -p

# 添加路径筛选

$ git log -- PATH

# 限制数量

$ git log -n NUM

$ git log -5

# 指定分支/标签/提交的历史

$ git log HEAD

如果希望查看当前其他分支的最新提交

$ git branch -v

bump-py3-pytest-asyncio-1.2.0 072086e312b community/py3-pytest-asyncio: upgrade to 1.2.0

lazydocker 729c43ddb8b community/lazydocker: add runtime depends ncurses

* master 00c9c05d721 [ahead 186] main/{kea,pgpool}: rebuild against postgresql 18

new-linyaps-box 9fc79988ded testing/linyaps-box: new aport

new-microsocks 29e2abdbc99 testing/microsocks: new aport

git-diff

对比差异,观察修改。下面举例说明顺位规律,先创建两次提交,针对同一文件做修改:

# 反序输出,从上到下

$ git log --oneline --reverse -p

221152d 111 <<< 第一次提交

diff --git a/hello b/hello

new file mode 100644

index 0000000..2e3e313

--- /dev/null

+++ b/hello

@@ -0,0 +1 @@

+第一次增加

c95a70b (HEAD -> main) 222 <<< 第二次提交

diff --git a/hello b/hello

index 2e3e313..6c27065 100644

--- a/hello

+++ b/hello

@@ -1 +1,2 @@

第一次增加

+第二次增加

git diff期待两个位置参数,旧提交在前,新提交在后。

$ git diff 221152d c95a70b

diff --git a/hello b/hello

index 2e3e313..6c27065 100644

--- a/hello

+++ b/hello

@@ -1 +1,2 @@

第一次增加

+第二次增加

接下来对文件进行修改,添加修改进暂存区,再次修改,结果如下:

$ git blame -s hello

^221152d 1) 第一次增加

c95a70bf 2) 第二次增加

00000000 3) 暂存区增加(未提交)

00000000 4) 工作区增加

工作区 vs 暂存区

$ git diff

diff --git a/hello b/hello

index e364217..9332b3e 100644

--- a/hello

+++ b/hello

@@ -1,3 +1,4 @@

第一次增加

第二次增加

暂存区增加(未提交)

+工作区增加

暂存区 vs HEAD

$ git diff --staged

$ git diff --cached

diff --git a/hello b/hello

index 6c27065..e364217 100644

--- a/hello

+++ b/hello

@@ -1,2 +1,3 @@

第一次增加

第二次增加

+暂存区增加(未提交)

工作区 vs HEAD

$ git diff HEAD

$ git diff HEAD

diff --git a/hello b/hello

index 6c27065..9332b3e 100644

--- a/hello

+++ b/hello

@@ -1,2 +1,4 @@

第一次增加

第二次增加

+暂存区增加(未提交)

+工作区增加

生成补丁的格式为Unified Diff Format,一种标准化的补丁格式,被广泛用于软件开发和版本控制系统。

$ git diff

diff --git a/hello b/hello

index e364217..9332b3e 100644

--- a/hello

+++ b/hello

@@ -1,3 +1,4 @@

第一次增加

第二次增加

暂存区增加(未提交)

+工作区增加

对于补丁来说,前两行算注释可以删掉,也可以手动增加一点描述信息。

重要的部分从@@行开始,这是变更块头(chunk header)描述了修改发生的上下文:

@@ -旧版本起始行,旧版本行数 +新版本起始行,新版本行数 @@

如果需要手动修改生成的补丁,注意补丁显示的代码行数要和变更块头的描述对应:

这是注释部分,可以随意写。以下两条命令生成的补丁上下文范围不同,但效果相同

$ git diff -U2 <<< 指定上下文范围2

diff --git a/hello b/hello

index e364217..9332b3e 100644

--- a/hello

+++ b/hello

@@ -2,2 +2,3 @@ <<<

第二次增加

暂存区增加(未提交)

+工作区增加

$ git diff -U3 <<< 指定上下文范围3

diff --git a/hello b/hello

index e364217..9332b3e 100644

--- a/hello

+++ b/hello

@@ -1,3 +1,4 @@ <<<

第一次增加

第二次增加

暂存区增加(未提交)

+工作区增加

git-email

用的不多,推荐教程

Learn to use email with git!

git-reset

软重置,将之前的提交“取消“,所有修改保留在暂存区

$ git reset --soft

Before: A - B - C (HEAD)

After: A - B (HEAD)

C 的修改在暂存区

默认混合重置,重置暂存区,修改保留在工作区

$ git reset [--mixed]

Before: A - B - C (HEAD)

After: A - B (HEAD)

C 的修改在工作区(未暂存)

硬重置,丢弃所有未提交的修改,完全回退到指定提交的状态

$ git reset --hard

Before: A - B - C (HEAD) + 工作区修改

After: A - B (HEAD) # 完全回到B的状态,所有修改丢失

硬重置很危险,如果误删可以尝试恢复:

# 查看所有操作历史

$ git reflog

# 找到重置前的提交哈希

$ git reset --hard HEAD@{1} # 恢复到前一个状态

恢复历史将会在git gc后清空。

git-rebase

更新当前分支到主分支最新状态

# 初始状态

A - B - C (main)

\

D - E (feature)

$ git checkout feature

$ git rebase main

# 变基后状态

A - B - C (main)

\

D' - E' (feature)

交互式操作提交

# 不包含起点

$ git rebase -i 基准OID

# 修改最后5个提交

$ git rebase -i HEAD~5

# 把其中的pick改为edit

$ git add

$ git commit --amend

$ git rebase --continue

注意rebase会修改基准提交之后所有提交的Oid

git-bundle

如何把本地的仓库备份或发送给别人

$ git clone --mirror https://github.com/alpinelinux/apk-tools.git

$ cd apk-tools

$ git bundle create apk-tools.bundle --all

生成的bundle文件就是一个完整仓库的打包,企业微信或者U盘发送后,再clone出来就行

$ du -sh apk-tools.bundle

4.1M apk-tools.bundle

$ git clone --bare apk-tools.bundle <new directory>

如果都是自己的电脑有SSH,直接clone就行

$ git clone n5105:~/dotfiles

正克隆到 'dotfiles'...

remote: Enumerating objects: 23, done.

remote: Counting objects: 100% (23/23), done.

remote: Compressing objects: 100% (19/19), done.

remote: Total 23 (delta 4), reused 0 (delta 0), pack-reused 0 (from 0)

接收对象中: 100% (23/23), 完成.

处理 delta 中: 100% (4/4), 完成.

Git的内部优化算法

理论上讲Git中有三个大类别的对象:Commit、Tree、Blob,具体到解析时还有Commit的同类Tag及Note。

这些对象以各自Object的hash作为Oid索引,经zlib压缩后保存在.git/objects下的文件中,

纯正文件系统驱动,并在需要时被解析。

Git 的数据结构为写多读少设计,因此其他程序应避免将 Git 作为数据库使用。

CommitGraph

Git中的每次提交都会创建对应的CommitObject,但是当需要遍历仓库历史的时候, 大量读就成了一个问题。 Git并没有在Commit中描述这次提交修改了哪些文件,所以若要知晓给定文件的最后修改日期,过程较为艰难:

- 获取Commit的TreeOid与Parent Commit的TreeOid

- 在两个Tree Object中遍历,查找修改的文件

- 检查给定文件是否在本次Commit中修改

- 重复上述操作,直到两次提交的树之间存在期望差异

Git内部在第二步和第三步之间有Diff优化,仅对比给定的路径, 但整体在没有对应数据结构的情况下进行类似的结构化查询还是相当消耗性能, 面对稍微大一点的仓库,时间来到秒级:

$ /usr/bin/time git -c core.commitGraph=false log --oneline -n 10 community/xmake/

81380060446 community/xmake: upgrade to 2.9.9

7c21bea5624 */*: replace non-POSIX find -not option

a92fe0ba060 community/xmake: upgrade to 2.9.7

12374870a8f community/xmake: upgrade to 2.9.6

12c188ec967 community/xmake: upgrade to 2.9.5

0096aeef07c community/xmake: upgrade to 2.9.4

4b130eb7f5a community/xmake: upgrade to 2.9.3

d516ffbb476 community/xmake: upgrade to 2.9.2

d74b311e776 community/xmake: move from testing

real 0m 51.11s

user 0m 41.44s

sys 0m 9.56s

Git在2.18版本后引入了提交图(CommitGraph)的概念,保存提交相关的额外索引信息到

.git/objects/info/commit-graph。

针对每个对象,使用独立的布隆过滤器对提交修改做缓存,理想情况下,最快的查询条件为:

# 激进垃圾回收并repack

$ git gc --aggressive

# 创建带有路径修改信息的提交图索引

$ git commit-graph write --changed-paths

经过上述修改性能提升明显:

$ /usr/bin/time git -c core.commitGraph=true log --oneline -n 10 community/xmake/

81380060446 community/xmake: upgrade to 2.9.9

7c21bea5624 */*: replace non-POSIX find -not option

a92fe0ba060 community/xmake: upgrade to 2.9.7

12374870a8f community/xmake: upgrade to 2.9.6

12c188ec967 community/xmake: upgrade to 2.9.5

0096aeef07c community/xmake: upgrade to 2.9.4

4b130eb7f5a community/xmake: upgrade to 2.9.3

d516ffbb476 community/xmake: upgrade to 2.9.2

d74b311e776 community/xmake: move from testing

real 0m 1.99s

user 0m 1.17s

sys 0m 0.81s

扩展阅读:

- Git - git-commit-graph Documentation

- Supercharging the Git Commit Graph - Azure DevOps Blog

- Updates to the Git Commit Graph Feature - Azure DevOps Blog

Packfile

算法部分暂时略,核心思想就是差异压缩:

- 所有对象按照Oid顺序保存方便mmap与二分

- 在文件开头创建范围索引

- 对象之间按照窗口期查找“基对象”进行差异压缩

- 多个Packfile之间创建Oid索引

经过差异压缩,体积可实现有20倍的缩小。接下来进行演示

读一点随机数模拟文件内容

$ head -c 500 /dev/urandom | base64 | head -n 50 > random_output.txt

在这个文件的基础上创建文件2

$ cp random_output.txt random_output_2.txt

$ echo "add new line" >> random_output_2.txt

直接添加提交,Git不会主动repack压缩,此时是原始Loose Objects存储

$ ls -lh

总计 8.0K

-rw-rw-r-- 1 anguoli anguoli 690 11月11日 22:12 random_output_2.txt

-rw-rw-r-- 1 anguoli anguoli 677 11月11日 22:09 random_output.txt

$ tree -h .git/objects/

[ 160] .git/objects/

├── [ 60] 02

│ └── [ 556] 3dc71e0501e56c41bc7a2b6236f167c7094360 <<<

├── [ 60] 06

│ └── [ 112] ffbb31a44b95173b16baa580941ce54984cb04

├── [ 60] c3

│ └── [ 567] c41712bdc2d4c2de08aee19d8f3e319fb82e83 <<<

├── [ 60] fd

│ └── [ 89] 040d11c4b1b4af03ac409dbefbf6fb94c50b1c

├── [ 40] info

└── [ 40] pack

7 directories, 4 files

$ git cat-file -s 023dc71e

677

通过手动gc达成repack压缩

$ git gc

枚举对象中: 4, 完成.

对象计数中: 100% (4/4), 完成.

使用 8 个线程进行压缩

压缩对象中: 100% (3/3), 完成.

写入对象中: 100% (4/4), 完成.

总共 4(差异 1),复用 4(差异 1),包复用 0(来自 0 个包)

$ tree -h .git/objects/

[ 80] .git/objects/

├── [ 80] info

│ ├── [1.1K] commit-graph

│ └── [ 54] packs

└── [ 100] pack

├── [1.2K] pack-6184e7108e795f0abc08d03baa4d2b49cd6d5d80.idx

├── [ 805] pack-6184e7108e795f0abc08d03baa4d2b49cd6d5d80.pack <<<

└── [ 68] pack-6184e7108e795f0abc08d03baa4d2b49cd6d5d80.rev

3 directories, 5 files

$ git verify-pack -v .git/objects/pack/pack-6184e7108e795f0abc08d03baa4d2b49cd6d5d80.pack

06ffbb31a44b95173b16baa580941ce54984cb04 commit 144 107 12

023dc71e0501e56c41bc7a2b6236f167c7094360 blob 677 549 119

c3c41712bdc2d4c2de08aee19d8f3e319fb82e83 blob 21 33 668 1 023dc71e0501e56c41bc7a2b6236f167c7094360

fd040d11c4b1b4af03ac409dbefbf6fb94c50b1c tree 92 84 701

非 delta:3 个对象

链长 = 1: 1 对象

.git/objects/pack/pack-6184e7108e795f0abc08d03baa4d2b49cd6d5d80.pack: ok

最后分别显示的是

<unpack-size> <size-in-packfile> <offset-in-packfile>

Git周边生态及开发

代码托管

- https://github.com

- https://about.gitlab.com/

- https://gitee.com/ 用了很多前者的基建

- https://gogs.io/ CVE修得少,不推荐

- https://about.gitea.com/ MIT,前者的fork

- https://forgejo.org/ GPL,前者的fork

- https://sourcehut.org/ Old School

- https://git.zx2c4.com/cgit/about/ 只读网页

- https://github.com/sitaramc/gitolite 无界面

- https://www.gerritcodereview.com/ 补丁审阅

其他链接:

- https://en.wikipedia.org/wiki/Comparison_of_source-code-hosting_facilities

- https://en.wikipedia.org/wiki/Forge_(software)#Examples

- https://onedev.io/ Java,v2ex有创始人

- https://pagure.io/ Fedora家的

- https://gerrit.googlesource.com/gitiles Gerrit搭档

- https://radicle.xyz/ Web3分布式

- https://forge.lindenii.org/

- https://github.com/yuki-kimoto/gitprep

- https://github.com/gitblit-org/gitblit

- https://gitlist.org/ PHP只读

- https://github.com/PGYER/codefever 蒲公英家的

- https://github.com/oxalorg/stagit 静态页面

当从GitHub拉仓库的时候,如果选择SSH则地址如下:

>>> [email protected]:user/repo.git

约等于SSH中git用户在操作github.com这个Host的user/repo.git路径下的仓库。

对个人来说最简单的情况不需要考虑权限,就是直接用SSH地址。

鉴权 & 认证

// 服务端与本地如何交互

// SSH认证

// Hooks鉴权

ChangeId

开源项目

- https://github.com/libgit2/libgit2 Pure C

- https://github.com/go-git/go-git Pure Go

- https://github.com/GitoxideLabs/gitoxide Pure Rust

- https://github.com/FredrikNoren/ungit Pure JavaScript

- https://gitlab.com/gitlab-org/gitaly/ Git RPC

Git 提交代次

期望

为每个 Commit 保存它的 generation 信息到数据库, 代次(深度)信息是「祖先跳表」方法的基础。

做法

设置根提交的 generation 为 0,后续子代依次 +1

UPDATE

commits

SET

generation = parent.generation + 1

FROM

commits AS parent

WHERE

commits.generation IS NULL

AND parent.generation IS NOT NULL

AND commits.repository_id = parent.repository_id

AND commits.parent_hash = parent.commit_hash

;

CREATE INDEX IF NOT EXISTS idx_commits_null_generation

ON commits(repository_id, parent_hash)

WHERE generation IS NULL;

CREATE INDEX IF NOT EXISTS idx_commits_parent_lookup

ON commits(repository_id, commit_hash, generation)

WHERE generation IS NOT NULL;

循环

上述 SQL 只能更新一个层面的 Commit,因此丢在 do-while 循环中反复执行

int rows_affected = 0;

sqlite3_stmt *stmt = stmts[STMT_UPDATE_GENERATION];

do {

sqlite3_exec(connection, "BEGIN TRANSACTION;", NULL, NULL, NULL);

sqlite3_reset(stmt);

sqlite3_step(stmt);

rows_affected = sqlite3_changes(connection);

sqlite3_exec(connection, "COMMIT;", NULL, NULL, NULL);

} while (rows_affected > 0);

障碍

速度还是太慢了,即使有(缺省)索引依然需要全表扫描。

$ cat update-generation.sql | sqlite3 stage.db

QUERY PLAN

|--SCAN commits USING INDEX idx_commits_null_generation

`--SEARCH parent USING COVERING INDEX idx_commits_parent_lookup (repository_id=? AND commit_hash=? AND generation>?)

对于有 26 万个提交的 aports 测试用例来说,循环完成需要 4 个多小时。

投降

之前在检测 Commit 会修改哪些文件的时候已经投降过一次了,现在只能继续投降。

抱住 Git 二进制的大腿,尝试逆序输出解析。

$ git log --pretty=format:%n%H --name-only --first-parent --reverse

%H显示完整 CommitHash%n显示一个\nname-only输出当前提交涉及修改的文件名first-parent单线遍历reverse逆序输出

成本

投降之前评估一下成本,理论上来说逆序应该更耗时,因为正序是 FIFO,逆序需要状态。 但是实际测试区别不明显,甚至逆序耗时更短?

$ hyperfine "git log --pretty=format:%H --name-only --first-parent" \

"git log --pretty=format:%H --name-only --first-parent --reverse"

Benchmark 1: git log --pretty=format:%H --name-only --first-parent

Time (mean ± σ): 233.308 s ± 1.055 s [User: 209.537 s, System: 22.922 s]

Range (min … max): 232.254 s … 235.719 s 10 runs

Benchmark 2: git log --pretty=format:%H --name-only --first-parent --reverse

Time (mean ± σ): 232.894 s ± 0.565 s [User: 208.993 s, System: 23.075 s]

Range (min … max): 232.023 s … 233.930 s 10 runs

Summary

git log --pretty=format:%H --name-only --first-parent --reverse ran

1.00 ± 0.01 times faster than git log --pretty=format:%H --name-only --first-parent

$ /usr/bin/time -v git log --pretty=format:%H --name-only --first-parent > /dev/null

Command being timed: "git log --pretty=format:%H --name-only --first-parent"

User time (seconds): 208.61

System time (seconds): 22.89

Percent of CPU this job got: 99% <<< 单线程进程,CPU 满载

Elapsed (wall clock) time (h:mm:ss or m:ss): 3m 52.31s

Average shared text size (kbytes): 0

Average unshared data size (kbytes): 0

Average stack size (kbytes): 0

Average total size (kbytes): 0

Maximum resident set size (kbytes): 669828 <<< 最大内存占用 600M

Average resident set size (kbytes): 0

Major (requiring I/O) page faults: 0

Minor (reclaiming a frame) page faults: 12839624

Voluntary context switches: 1

Involuntary context switches: 367 <<< 别的都看不懂

Swaps: 0

File system inputs: 0

File system outputs: 0

Socket messages sent: 0

Socket messages received: 0

Signals delivered: 0

Page size (bytes): 4096

Exit status: 0

$ /usr/bin/time -v git log --pretty=format:%H --name-only --first-parent --reverse > /dev/null

Command being timed: "git log --pretty=format:%H --name-only --first-parent --reverse"

User time (seconds): 210.01

System time (seconds): 23.14

Percent of CPU this job got: 99%

Elapsed (wall clock) time (h:mm:ss or m:ss): 3m 53.98s

Average shared text size (kbytes): 0

Average unshared data size (kbytes): 0

Average stack size (kbytes): 0

Average total size (kbytes): 0

Maximum resident set size (kbytes): 612564

Average resident set size (kbytes): 0

Major (requiring I/O) page faults: 0

Minor (reclaiming a frame) page faults: 12762389

Voluntary context switches: 2

Involuntary context switches: 475

Swaps: 0

File system inputs: 0

File system outputs: 0

Socket messages sent: 0

Socket messages received: 0

Signals delivered: 0

Page size (bytes): 4096

Exit status: 0

结果

qaq^n5105 bushi/bushi-index main*

$ ./build/bushi-index -t stage.db -p ~/aports/.git > log

qaq^n5105 bushi/bushi-index main* 4m52s

不到 5 分钟!满意,收工!

链接

- https://git-scm.com/docs/git-log

- https://sqlite.org/partialindex.html

- https://github.com/sharkdp/hyperfine

Git 祖先跳表

- 2025-05-04 介绍一下 bushi 所使用的祖先跳表

- 2025-12-19 更新了表结构,刷新字符串并补充

场景

在 GitWeb 中指定 Commit 的详情页面显示在远端的存在情况

- Branches containing commit

- Tags containing commit

这种请求需要判断 Reference 对应的 Commit 是否可达指定 Commit

限制

仅考虑 Commit 的第一个 Parent Commit,否则从链表退化到树,复杂程度翻倍

Note

With the –changed-paths option, compute and write information about the paths changed between a commit and its first parent.

原版 git-commit-graph 同样设计如此

原理

如果什么都不做,判断只有两步:

- 对比 generation 是否合理

- 向上「依次」遍历到 generation 相等,检查是否相遇

对于可能超过 10 万提交的成熟项目,CTE 的耗时到秒级。 如果有 100 个分支,请求处理时间超出 1 分钟。

bushi 在表中以跳表形式额外存储了每个 Commit 的「祖先」信息,新判断为:

- 对比 generation 是否合理,计算得到差值

- 对 generation 的差值转二进制 BIN,1 跳 0 不跳,得到跳表节点

- 向上按照「跳表」遍历到 generation 相等,检查是否相遇

时间复杂度从 O(n) 降低到了 O(log n)

验证

选择 Alpine Linux 的软件包构建脚本仓库深度距离为 100K 的两个提交,对应的 Commit 如下

sqlite> SELECT * FROM commits WHERE generation in (100, 100000);

commit_id commit_hash parent_hash generation repository_id

--------- ---------------------------------------- ---------------------------------------- ---------- -------------

237494 3845839a16f3162c2362e9271f59fe52cef7bf83 44a369d15ac69464584099d339a0e1ec1ec7fa66 100 1

137594 73a0fc8c219239f2df973722cf1bd75ce9aa1bf7 d435959ada011bdf44a535aa1297ad86d0f0f235 100000 1

两者 generation 之差转为二进制数得到 2 的 N 次幂

>>> bin(99900)

'0b11000011000111100'

顺着 BIN 的二进制数,位数表示 exponent,1 跳 0 不跳

16 15 10 9 5 4 3 2

1 1 0 0 0 0 1 1 0 0 0 1 1 1 1 0 0

假设有下面的 STMT 然后以绑定参数的形式执行

SELECT

ancestors.commit_id,

exponent,

ancestor_id,

generation

FROM

ancestors

JOIN

commits

ON

commits.commit_id = ancestors.commit_id

WHERE

commits.commit_id = ?1

AND exponent = ?2;

从左跳也是一样的,但是右边开始可能有利于 SQLite 缓存命中

STMT(137594, 2) => 137598

STMT(137598, 3) => 137606

STMT(137606, 4) => 137622

STMT(137622, 5) => 137654

STMT(137654, 9) => 138166

STMT(138166, 10) => 139190

STMT(139190, 15) => 171958

STMT(171958, 16) => 237494

最终得到 commit_id 与目标相同,两者位于同一分支中。

友商

GitLab 家的 Gitaly 提供了 RPC-Git 接口 ListBranchNamesContainingCommit

ListBranchNamesContainingCommit finds all branches under

refs/heads/that contain the specified commit. The response is streamed back to the client to divide the list of branches into chunks.

不过只有对 Git 的封装

type containingRequest interface {

GetCommitId() string

GetLimit() uint32

}

func containingArgs(...) []string {

args := []string{fmt.Sprintf("--contains=%s", req.GetCommitId())}

if limit := req.GetLimit(); limit != 0 {

args = append(args, fmt.Sprintf("--count=%d", limit))

}

return args

}

func listRefNames(...) error {

flags := []gitcmd.Option{

gitcmd.Flag{Name: "--format=%(refname)"},

}

for _, arg := range extraArgs {

flags = append(flags, gitcmd.Flag{Name: arg})

}

cmd, err := repo.Exec(ctx, gitcmd.Command{

Name: "for-each-ref",

Flags: flags,

Args: []string{prefix},

}, gitcmd.WithSetupStdout())

...

}

- https://gitlab.com/gitlab-org/gitaly/-/issues/1744

- https://gitlab.com/gitlab-org/gitaly/-/merge_requests/537

- https://gitlab.com/gitlab-org/gitaly/-/blob/v18.7.0/internal/gitaly/service/ref/refnames_containing.go

再去看 Gitea 家,也是 Git 命令的封装

func (repo *Repository) ListOccurrences(ctx context.Context, refType, commitSHA string) ([]string, error) {

cmd := gitcmd.NewCommand()

switch refType {

case "branch":

cmd.AddArguments("branch")

case "tag":

cmd.AddArguments("tag")

}

stdout, _, err := cmd.AddArguments("--no-color", "--sort=-creatordate", "--contains").AddDynamicArguments(commitSHA).RunStdString(ctx, &gitcmd.RunOpts{Dir: repo.Path})

...

}

实现

我们使用的是根正苗红的 SQLite 数据,因此只需要根据表结构放置触发器即可

CREATE TABLE IF NOT EXISTS commits(

commit_id INTEGER PRIMARY KEY AUTOINCREMENT,

commit_hash TEXT NOT NULL,

parent_hash TEXT, -- only first parent

generation INTEGER, -- NOT NULL after stage2

repository_id INTEGER NOT NULL

) STRICT;

-- 索引略

CREATE TABLE IF NOT EXISTS ancestors(

commit_id INTEGER NOT NULL,

exponent INTEGER NOT NULL, -- 2^n generation

ancestor_id INTEGER NOT NULL, -- aka. commit_id

PRIMARY KEY(commit_id, exponent)

) WITHOUT ROWID, STRICT;

CREATE TRIGGER IF NOT EXISTS tgr_ancestor

AFTER UPDATE OF generation ON commits

FOR EACH ROW

WHEN NEW.parent_hash IS NOT NULL

BEGIN

-- contents

END;

触发器绑定在 commits 表中的 generation 字段中, 因为这个字段的更新意味着父代已填充完毕、数据完整。

INSERT INTO ancestors(commit_id, exponent, ancestor_id)

WITH RECURSIVE skip_list_cte(commit_id, exponent, ancestor_id) AS(

SELECT

NEW.commit_id,

0 AS exponent, -- 亲爹记录是从 commits 表直接查来的

c.commit_id AS ancestor_id

FROM

commits AS c

WHERE

repository_id = NEW.repository_id

AND commit_hash = NEW.parent_hash

UNION ALL -- 标准 CTE 语法、没有爆炸风险

SELECT

s.commit_id,

s.exponent + 1, -- 后续记录是把亲爹的记录复制,辈分 +1

a.ancestor_id

FROM

skip_list_cte AS s

INNER JOIN

ancestors AS a

ON

a.commit_id = s.ancestor_id

AND a.exponent = s.exponent

)

SELECT

commit_id, exponent, ancestor_id

FROM

skip_list_cte

WHERE

ancestor_id IS NOT NULL;

结语

如果分支数量不多而提交数量很大,这样做没什么问题,时间换空间同时不用考虑一致性问题

但是对于那种一下子 23 万个标签的奇怪仓库,还需要进一步考虑:

- 每个提交携带布隆过滤器缓存 Reference?每次全量重刷?

- 非 First Parent Commit 怎么办?

- 能不能把上面的业务操作封装为扩展插件?

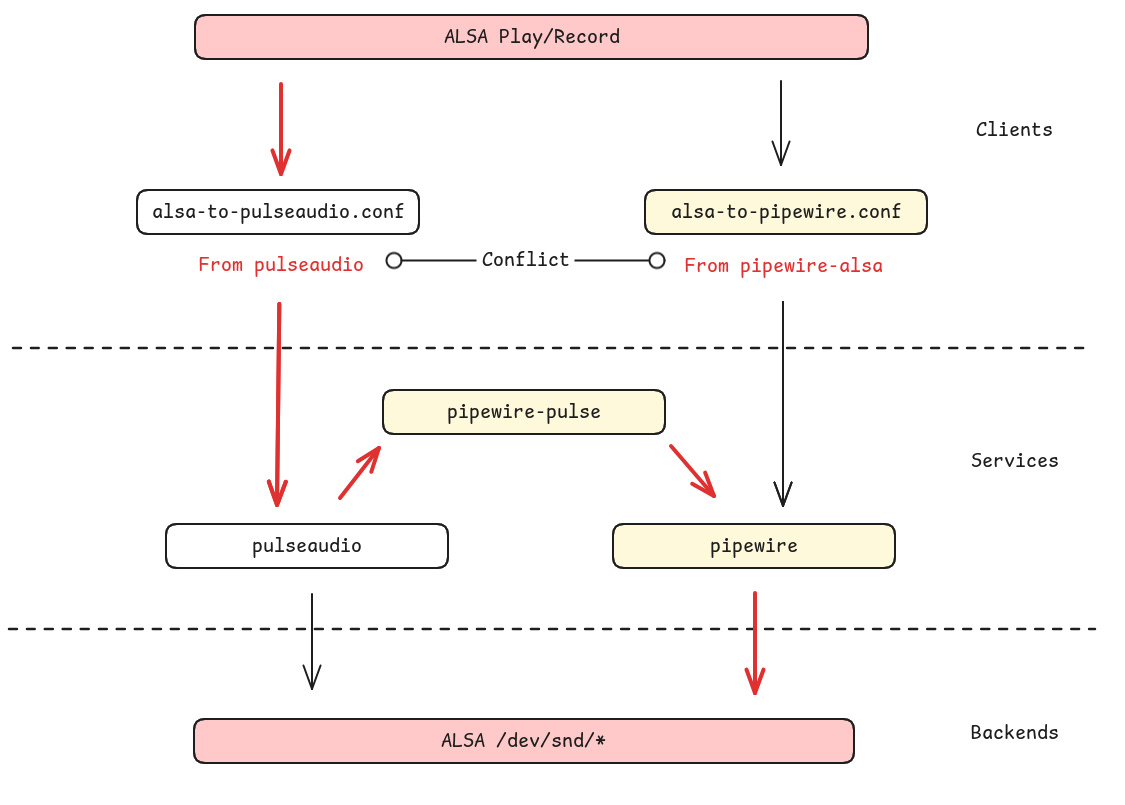

alsa.conf

发现我们 deepin 系统的音频子系统存在拧巴的依赖关系。

接口

当前播放音乐有以下几个相对底层的接口:

- ALSA 接口

- PipeWire 接口

- PulseAudio 接口

其中,ALSA 可以通过「配置文件」默认将播放转发到 PulseAudio 或 PipeWire 接口。 PipeWire 提供了 PulseAudio 兼容接口,以 pipewire-pulse 包的形式存在:

$ apt-file list pipewire-pulse

pipewire-pulse: /usr/bin/pipewire-pulse

pipewire-pulse: /usr/lib/systemd/user/pipewire-pulse.service

pipewire-pulse: /usr/lib/systemd/user/pipewire-pulse.socket

pipewire-pulse: /usr/share/glib-2.0/schemas/org.freedesktop.pulseaudio.gschema.xml

pipewire-pulse: /usr/share/pipewire/pipewire-pulse.conf

$ ls -l /usr/bin/pipewire-pulse

lrwxrwxrwx 7 root root 8 2025年 7月 2日 /usr/bin/pipewire-pulse -> pipewire

在纯正的 PulseAudio 系统上,ALSA 接口由 PulseAudio 兼容

$ apt-file list pulseaudio | grep /etc/alsa/co

pulseaudio: /etc/alsa/conf.d/99-pulse.conf <<< 设置 alsa 默认输出

$ cat /etc/alsa/conf.d/99-pulse.conf

# PulseAudio alsa plugin configuration file to set the pulseaudio plugin as

# default output for applications using alsa when pulseaudio is running.

hook_func.pulse_load_if_running {

lib "libasound_module_conf_pulse.so" <<< alsa-plugins 提供

func "conf_pulse_hook_load_if_running"

}

@hooks [

{

func pulse_load_if_running

files [

"/usr/share/alsa/pulse-alsa.conf" <<< pulseaudio 提供

]

errors false

}

]

如果 ALSA 库连不上 PulseAudio(没有运行、或没有权限)就 fallback 到默认物理声卡。

我们的 25 系统默认同时预装 PulseAudio 和 PipeWire,具体到包是:

- pulseaudio

- pipewire

- pipewire-pulse

- wirepulmber

在 Ubuntu 新系统上还有一个额外的 pipewire-alsa 提供 ALSA 的兼容

$ apt-file list pipewire-alsa

pipewire-alsa: /etc/alsa/conf.d/50-pipewire.conf

pipewire-alsa: /etc/alsa/conf.d/99-pipewire-default.conf <<< 设置默认转发

pipewire-alsa: /usr/lib/x86_64-linux-gnu/alsa-lib/libasound_module_ctl_pipewire.so

pipewire-alsa: /usr/lib/x86_64-linux-gnu/alsa-lib/libasound_module_pcm_pipewire.so

pipewire-alsa: /usr/share/alsa/alsa.conf.d/50-pipewire.conf

pipewire-alsa: /usr/share/alsa/alsa.conf.d/99-pipewire-default.conf

但是我们没有(pipewire-alsa 与 pulseaudio 两包冲突),

所以此时系统里的 APP 如果调用了 ALSA 相关接口播放,那处理路径为:

- ALSA 接口转发到 PulseAudio 接口

- PulseAudio 接口由 PipeWire 兼容

ALSA 转发的配置文件来自 PulseAudio,缺少转发就会让客户端尝试直接打开 /dev/snd

设备,而这些节点一般被 PipeWire 和 WirePlumber 进程占据,无法正常播放。

$ aplay xxx.wav

ALSA lib pcm_dmix.c:1000:(snd_pcm_dmix_open) unable to open slave

aplay: main:850: audio open error: 设备或资源忙

aplay

配置文件对当前系统最主要的功能是为 aplay 等提供 default 虚拟播放设备

$ aplay -L | grep -A 1 default

default

Playback/recording through the PulseAudio sound server

例如安装 PulseAudio 时转发到 PA 的相关接口

$ strace -e openat aplay /usr/share/sounds/deepin/stereo/desktop-login.wav

openat(AT_FDCWD, "/etc/ld.so.cache", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/lib/x86_64-linux-gnu/libasound.so.2", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/lib/x86_64-linux-gnu/libc.so.6", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/lib/x86_64-linux-gnu/libm.so.6", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/usr/lib/locale/locale-archive", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/usr/share/alsa/alsa.conf", O_RDONLY) = 3

openat(AT_FDCWD, "/etc/alsa/conf.d", O_RDONLY|O_NONBLOCK|O_CLOEXEC|O_DIRECTORY) = 3

...

openat(AT_FDCWD, "/etc/alsa/conf.d/99-pulse.conf", O_RDONLY) = 3

...

openat(AT_FDCWD, "/lib/x86_64-linux-gnu/alsa-lib/libasound_module_conf_pulse.so", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/etc/ld.so.cache", O_RDONLY|O_CLOEXEC) = 3

openat(AT_FDCWD, "/lib/x86_64-linux-gnu/libpulse.so.0", O_RDONLY|O_CLOEXEC) = 3

alsa-lib

配置文件的解析在 alsa-lib 库,宏定义文件入口 /usr/share/alsa。

config_file_load 函数中使用 scandir64(alphasort64)

按照按照序号依次扫描加载以 .conf 结尾的配置。

$ ls /etc/alsa/conf.d/

10-rate-lav.conf 50-oss.conf 60-vdownmix.conf

10-samplerate.conf 50-pulseaudio.conf 98-usb-stream.conf

10-speexrate.conf 60-a52-encoder.conf 99-pulseaudio-default.conf.example

50-arcam-av-ctl.conf 60-speex.conf 99-pulse.conf

50-jack.conf 60-upmix.conf

配置文件默认是 + merge + create,同样的标识符号还有

- merge、? 缺省默认、! 覆盖(常用来设置默认音频设备)。

u 排在 i 后面,所以 99-pipe 和 99-pulse 配置文件同时存在时后者会覆盖前者。

pipewire-alsa

Debian 上游社区已经在 3 年前讨论过这个问题,此处的争执更多在语义完整性上: 当 PulseAudio 作为音频服务时,ALSA 被 PulseAudio 代理; 现在 PipeWire 接替了 PulseAudio,ALSA 应该被 PipeWire 直接代理还是因为兼容 PulseAudio 被兼容代理呢?

pipewire (0.3.60-1) unstable; urgency=medium

* pipewire-alsa: conflict with pulseaudio. (Closes: #1013276)

As long as the pulseaudio package is installed, ALSA clients will output

via PulseAudio instead of PipeWire. This is due to the order of their

respective configs files in /etc/alsa/conf.d/.

-- Dylan Aïssi <[email protected]> Fri, 11 Nov 2022 14:55:34 +0100

pipewire (0.3.64-1) unstable; urgency=medium

* pipewire-pulse: recommends pipewire-alsa

When the pulseaudio package is installed, all sound are routed through

pulseaudio. PipeWire should mimic this behavior by adding the recommend

between pipewire-pulse and pipewire-alsa. Thus all sound are routed

through pipewire.

-- Dylan Aïssi <[email protected]> Tue, 17 Jan 2023 10:38:57 +0100

pipewire (0.3.64-3) experimental; urgency=medium

* pipewire-pulse: do not recommend pipewire-alsa (Closes: #1029377)

* Build a new metapackage pipewire-audio depending on recommended pipewire

packages for a standard audio desktop use. Not knowing which packages

to install is a common source of bug reports. This metapackage should

help users to have a working configuration.

-- Dylan Aïssi <[email protected]> Tue, 24 Jan 2023 10:43:23 +0100

- https://bugs.debian.org/cgi-bin/bugreport.cgi?bug=1013276

- https://bugs.launchpad.net/ubuntu/+source/pipewire/+bug/1975823

- https://gitlab.freedesktop.org/pipewire/pipewire/-/issues/2255

- https://bugs.debian.org/cgi-bin/bugreport.cgi?bug=1029377

linyaps

测试时发现当前系统不装 pulseaudio 时 deepin-music 也正常工作, 咨询了玲珑组发现这里没怎么处理,运行时塞了一大堆东西进去。

$ ll-cli ps

应用 容器ID 进程ID

org.deepin.music 3149aa74d04a 7967

$ ll-cli enter org.deepin.music

(18280) ./libs/linglong/src/linglong/cli/cli.cpp:870 select container id "3149aa74d04ae73312c289b838050ee5873bea05db2c1715b92ecd3f1b9deab7"

$ cd /etc/alsa/conf.d/

$ ls -al 99-pulse.conf

lrwxrwxrwx 1 nobody nogroup 38 7月 2 2025 99-pulse.conf -> /usr/share/alsa/alsa.conf.d/pulse.conf

$ dpkg -S 99-pulse.conf

pulseaudio: /etc/alsa/conf.d/99-pulse.conf

因为配置文件转发在,绑定的 /run/user/1000/pulse/ 套字节也在,所以很不好的正常运行了。

New MkDot

MkDot 是一款 dotfiles 安装小工具,用于以较低的精神成本初始化新 Linux 系统。 这个帖子是一个伪实况,记录了小工具的构思及实现过程。

2026 年 1 月 6 日

需求

围绕 dotfile 为主题有几个概念我不喜欢,第一个是「管理」,其中 70% 是「同步」 10% 是「安全」。在我这里认为不对所以完全不需要考虑:

- 绝大多数同步依赖 Git,但是我并不觉得 Git 适合保存配置文件

- 配置文件放在 GitHub 不仅会在国内有访问问题,公开配置也放不了密钥

另一个概念还是「管理」,但是更偏向「功能」或者说工具「定位」,经过观察:

- 我的配置最多 200 行,用不着为此阅读 2000 字的文档学习一个似是而非的教程

- 再复杂的 dotfile 管理工具也不可能全自动托管,除非全部底裤交给 Nix

目前我有一个 U 盘,每次装系统手动复制一些文件过去。 因此小工具只需要把配置文件复制到正确的位置就能满足我的日常需求。

功能

脑海里浮现了一些功能相似的系统组件:cp、ln 和 install:

$ busybox install --help

BusyBox v1.37.0 (2025-12-16 14:19:28 UTC) multi-call binary.

Usage: install [-cdDsp] [-o USER] [-g GRP] [-m MODE] [-t DIR] [SOURCE]... DEST

Copy files and set attributes

-c Just copy (default)

-d Create directories

-D Create leading target directories

-s Strip symbol table

-p Preserve date

-o USER Set ownership

-g GRP Set group ownership

-m MODE Set permissions

-t DIR Install to DIR

其中的部分内容对本工具来说多余,比如 install 的权限和用户(直接复制就好), 剩下的部分直接照搬过来:

$ mkdot -h

usage: mkdot [-fins] TOPIC... BASE

or: mkdot [-fins] -t BASE TOPIC...

install dotfiles from TOPIC(s) to BASE

-f overwrite existing files (default)

-i prompt before overwriting (interactive)

-n no overwrite, skip existing files

-s create symbolic links instead of copying

-t BASE specify BASE directory for all TOPICs

参考知名备份工具 restic,它在工作时有三个参数:数据、动作、对象:

$ restic --repo /tmp/backup backup ~/work

本文小工具只有一个安装动作;数据由 CWD 和调用时的 TOPIC 两部分组合而成; 对象 BASE 是我们安装的目标路径,一般默认是用户家目录, 但是应当认可接 sudo 后安装到 etc 或者其他位置也 Ok 所以不可省略。

实现

首先想到的是 Rust,但是又即刻冷静下来——错误处理、非 UTF-8 路径处理、体积控制等等, 我都不会哈哈!PS:真的有人忍心为功能这么小的工具上 clap 和 thiserror 吗?

用 C 结合 POSIX 标准库搓搓,当当当当!顺便用 bats 套件糊了测试。

安全

搜了一下找到一个看起来信任度、维护度很高的 gocryptfs,文档也很完善

# 虽然是 go 写的但源里有

$ doas apk add gocryptfs

$ gocryptfs -speed

gocryptfs v2.6.1; go-fuse [vendored]; 2026-01-15 go1.25.6 linux/amd64

cpu: 13th Gen Intel(R) Core(TM) i5-13420H; with AES-GCM acceleration

AES-GCM-256-OpenSSL 2730.45 MB/s

AES-GCM-256-Go 5627.85 MB/s (selected in auto mode)

AES-SIV-512-Go 624.00 MB/s

XChaCha20-Poly1305-OpenSSL 1398.80 MB/s

XChaCha20-Poly1305-Go 2064.54 MB/s (selected in auto mode)

# 需要两个文件夹,一个存数据一个当挂载点

$ mkdir cipher plain

# 初始化数据,设置密码

$ gocryptfs -init cipher

# 加载 fuse 模块、解密、挂载

$ doas modprobe fuse

$ gocryptfs cipher/ plain/

# 卸载,因为有 suid 所以不需要 root

$ fusermount -u plain

结语

似乎可以结束了,但是 fuse 看起来还挺好玩,不知道能不能做点东西。

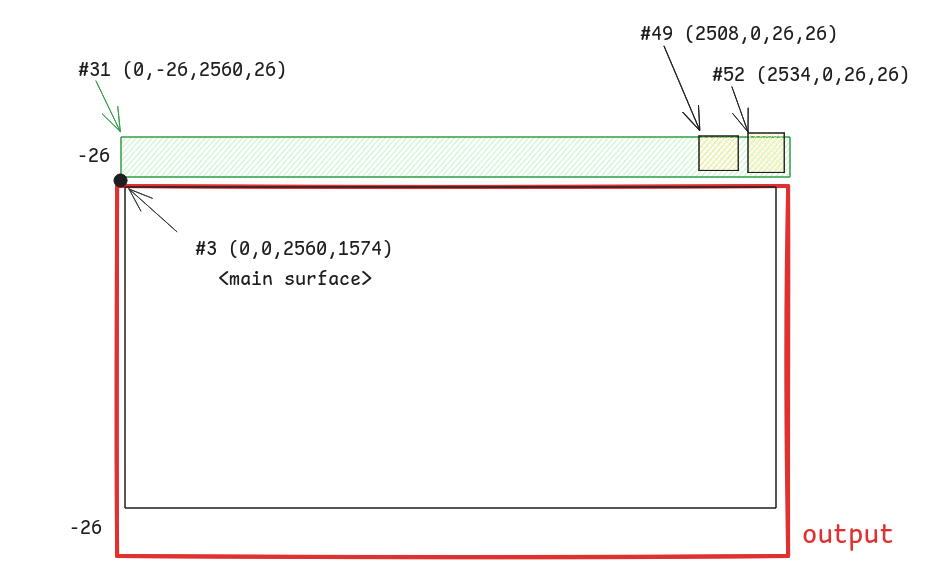

Foot Size Debug

Foot 是一个备受推荐、「心智」完善的 Wayland 终端模拟器。 但是在 Cage 合成器上,一直有个底部间隙的问题: Black strip at the bottom · Issue #254 · cage-kiosk/cage

环境

$ cage -- foot

$ cage -v

Cage version 0.2.1

$ foot --version

foot version: 1.25.0 +pgo +ime +graphemes -assertions

当前使用的显示器并未设置缩放,参数结果如 wlr-randr 所示:

DP-2 "YHY TYPE-C DXXXR499046S (DP-2)"

Make: YHY

Model: TYPE-C

Serial: DXXXR499046S

Physical size: 350x200 mm

Enabled: yes

Modes:

2560x1600 px, 60.000000 Hz (preferred, current)

Position: 0,0

Transform: normal

Scale: 1.000000

Adaptive Sync: disabled

先启动一个无关紧要的 Cage 作为 base 环境避免退出,

查看 XDG_RUNTIME_DIR 发现有 wayland-0,拉起一个 foot 进程:

$ export WAYLAND_DEBUG=1

$ export WAYLAND_DISPLAY=wayland-0

$ foot > foot.log 2>&1

日志

[2696020.284] {Default Queue} -> wl_display#1.get_registry(new id wl_registry#2)

[2696020.312] {Default Queue} -> wl_display#1.sync(new id wl_callback#3)

[2696020.446] {Display Queue} wl_display#1.delete_id(3)

Client 的日志打印,-> 是客户端的请求,其他是接收的事件。

为了方便把时间和 Quene 去掉,剩余的伪 FMT 如下:

{send ? " ->": ""}{interface->name}#{interface->id}.(args...)

When a client deletes an object that it had created, the server will send this event to acknowledge that it has seen the delete request.

TODO 为什么在 callback done 的事件到达之前 callback id 就双删了?

// src/wayland-client.c

WL_EXPORT struct wl_display *

wl_display_connect_to_fd(int fd)

{

wl_map_init(&display->objects, WL_MAP_CLIENT_SIDE);

wl_map_insert_at(&display->objects, 0, 0, NULL) // id = 0

display->proxy.object.id =

wl_map_insert_new(&display->objects, 0, display); // id = 1

在 libwayland 中,Client 侧 wl_display 全局对象的 id 始终默认为 1。

wl_registry#2.global(1, "wl_shm", 2)

-> wl_registry#2.bind(1, "wl_shm", 2, new id [unknown]#4)

wl_registry#2.global(2, "zwp_linux_dmabuf_v1", 4)

wl_registry#2.global(3, "wl_compositor", 6)

-> wl_registry#2.bind(3, "wl_compositor", 6, new id [unknown]#5)

wl_registry#2.global(4, "wl_subcompositor", 1)

-> wl_registry#2.bind(4, "wl_subcompositor", 1, new id [unknown]#6)

...

wl_callback#3.done(197) // 对应 .312 的 sync

-> wl_display#1.sync(new id wl_callback#3)

wl_display#1.delete_id(3)

有了 wl_display 后可以起 wl_registry 对象进而注册其他对象(接口),

Client 这边有的绑了有的没绑。一般这里会阻塞一下确保 Server 消息处理、派发完毕。

To mark the end of the initial burst of events, the client can use the

wl_display.sync requestimmediately after callingwl_display.get_registry.

wl_display_roundtrip(wl_display)

Block until all pending request are processed by the server

- wl_display_roundtrip_queue

- wl_display_sync // sync 有点像 await

- wl_display_dispatch_queue

- wl_callback_destroy // delete callback_id

到这里几个接口都绑好了,下面主要关注窗口相关的信息。

wl_output#17.geometry(0, 0, 350, 200, 0, "YHY", "TYPE-C", 0)

wl_output#17.mode(1, 2560, 1600, 60000)

wl_output#17.scale(1)

wl_output#17.name("DP-2")

wl_output#17.description("YHY TYPE-C DXXXR499046S (DP-2)")

wl_output#17.done()

屏幕缩放是 1 而且搜不到名字的杂牌,wl_output 是最好实现的 Wayland 接口。

-> wl_compositor#5.create_surface(new id wl_surface#3)

-> xdg_wm_base#12.get_xdg_surface(new id xdg_surface#24, wl_surface#3)

-> xdg_surface#24.get_toplevel(new id xdg_toplevel#25)

-> zxdg_decoration_manager_v1#13.get_toplevel_decoration(new id zxdg_toplevel_decoration_v1#26, xdg_toplevel#25)

-> zxdg_toplevel_decoration_v1#26.set_mode(2) // 客户端请求 SSD

-> wl_surface#3.commit()

-> wl_compositor#5.create_surface(new id wl_surface#27)

-> wl_subcompositor#6.get_subsurface(new id wl_subsurface#28, wl_surface#27, wl_surface#3)

...

xdg_toplevel#25.configure(2560, 1600, array[4])

zxdg_toplevel_decoration_v1#26.configure(1) // 合成器强制 CSD

xdg_surface#24.configure(198)

wl_surface#3 是主 surface 具有 toplevel,其下有若干 subsurface

wl_surface#3akaxdg_surface#24,xdg_toplevel#25wl_surface#27akawl_subsurface#28- …

-> xdg_surface#24.ack_configure(198) // ack

-> xdg_toplevel#25.set_min_size(10, 49)

-> xdg_surface#24.set_window_geometry(0, -26, 2560, 1600)

-> wl_subsurface#31.set_position(0, -26)

-> wl_subsurface#34.set_position(0, 0)

-> wl_subsurface#49.set_position(2508, 0)

-> wl_subsurface#52.set_position(2534, 0)

Wayland 客户端不知道自己的坐标,但是 subsurface 知道自己在父节点上的相对位置。

-> wl_shm#4.create_pool(new id wl_shm_pool#54, fd 15, 282624)

-> wl_shm_pool#54.create_buffer(new id wl_buffer#55, 0, 2560, 26, 10240, 0)

-> wl_shm_pool#54.create_buffer(new id wl_buffer#56, 266240, 26, 26, 256, 0)

-> wl_shm_pool#54.create_buffer(new id wl_buffer#57, 272896, 26, 26, 256, 0)

-> wl_surface#48.attach(wl_buffer#56, 0, 0)

-> wl_surface#48.damage_buffer(0, 0, 26, 26)

-> wl_surface#48.commit()

wl_shm_pool_create_buffer(

pool, // object

offset, // height * stride

width,

height,

stride, // align + width * bit

WL_SHM_FORMAT

);

10240 / 2560 = 4,刚好 4 * 8 = 32 对应到 WHM 的颜色格式

| Argument | Value | Description |

|---|---|---|

| argb8888 | 0 | 32-bit ARGB format, [31:0] A:R:G:B 8:8:8:8 little endian |

下面的 26 26 大小需要 256 的 stride,这里涉及到对齐等其他设计 (TODO 为什么前面的就不需要)

所以此处的间隙就是窗口顶部的标题栏,在 Cage 中窗口的位置尽量贴近显示器

// view.c

static void

view_maximize(struct cg_view *view, struct wlr_box *layout_box)

{

view->lx = layout_box->x;

view->ly = layout_box->y;

if (view->scene_tree) {

wlr_scene_node_set_position(&view->scene_tree->node, view->lx, view->ly);

}

view->impl->maximize(view, layout_box->width, layout_box->height);

}

这里的 lx 和 ly 都是窗口在 output-layout 中的绝对坐标,没有考虑到后续窗口自身的 https://wayland.app/protocols/xdg-shell#xdg_surface:request:set_window_geometry

在 tinywl 中,可以看到可能更正常一点的排布(没有主动设置),因为默认自带偏移:

// types/scene/xdg_shell.c

static void scene_xdg_surface_update_position(

struct wlr_scene_xdg_surface *scene_xdg_surface) {

struct wlr_xdg_surface *xdg_surface = scene_xdg_surface->xdg_surface;

wlr_scene_node_set_position(&scene_xdg_surface->surface_tree->node,

-xdg_surface->geometry.x, -xdg_surface->geometry.y);

wlr_scene 接口没什么能改的,还是 WM 自己看着办吧

// types/scene/wlr_scene.c

void wlr_scene_node_set_position(struct wlr_scene_node *node, int x, int y) {

if (node->x == x && node->y == y) {

return;

}

node->x = x;

node->y = y;

scene_node_update(node, NULL);

}

测试时发现 Treeland 也有这个问题。 https://github.com/linuxdeepin/treeland/issues/744

2026

每年结束回望的时候,不由得很失落,所以不如每年的总结就写写新年目标好了!

新年目标当然要写在新年的 SUMMARY 里、写在 2026 的开头。

内核补丁

2026 年承接 2025 年的一个内核补丁,希望能有机会做 10 个。 好吧是在说大话,能有 1-3 个就满足了。

Alpine Linux

去年在打包仓库有 166 个提交,今年稳住 200 个应该问题不大。 按照这个速度估计,2027 年可以尝试申请 Committer。

Wayland

2025 年年初的时候突然发现自己能看懂 wlroots 源码了,26 年应该可以把 WM 搓出来。

这里希望能把相关文档和教程翻修一下,做点小工具和朋友主持一次开源之夏的项目。

Git

去年发现 Git 一个 BUG(也许是),希望能学习下邮件列表并围绕这个问题练练手。

GitWeb 数据结构基本成型,网站就用 Rust 随便糊一糊,心情好的时候应该也不难做。

音频方面

26 年不出意外 PulseAudio 就要官宣倒闭了(除了一些小工具和客户端的部分), 不知道能不能做点啥,比如埋点土帮帮忙?

这一年肯定要学会 PipeWire 相关,这是我们的主要目标排在首位。 有很多角度可以下手学习:

- 配置文件

- 生命周期

- 数据结构

- 协议接口

- WirePlumber

希望能在社区混个脸熟,修几个 Issues 然后自己写点文档。

最后但也是重要的

许愿 12 点之前甚至 11 点爬上床开始早睡早起!

2026-01

1 月受到某 suit 事件的影响整体不太顺利,总觉得本月什么也没干就结束了。

mkdot

观察了一下,可以考虑开个 dotfile 管理的新坑。特点是只负责安装,不负责同步备份,

因此剩下的逻辑如 ln -s 或 install 般简单。

https://github.com/qaqland/mkdot

同步备份是一件很复杂的事情,不应该耦合在我对 dotfile 的需求中

- 绝大部分配置文件不需要 Git 历史记录,也不应该被 Git 管理

- 部分敏感数据放置在 GitHub 等开放平台不合适或者不方便

overthinkin

尝试把之前写的小工具们搓到一起。

aports

GTK2 清理工作稳步推进中,Python 会再次测试并尝试关单。 本月勤劳的 Alpine Linux 维护人 cece 离开了项目,感谢付出、希望 ta 能开心。

- https://gitlab.alpinelinux.org/alpine/aports/-/work_items/17848

- https://gitlab.alpinelinux.org/alpine/aports/-/issues/17558

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95104

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95130

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95391

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95440

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95510

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95659

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95660

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95662

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95744

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95745

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95746

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95757

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95768

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/95817

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96185

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96186

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96187

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96188

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96293

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96342

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96681

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96683

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96690

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96719

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96723

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96772

radxa q6a

已经在脑海里做好镜像了!虽然还没做好。

- dd 搞个文件,弄两个分区并挂载到目录

- rootfs 解压到根,从厂商镜像里把内核相关文件抠过来

- 挂载 dev sys 等,chroot 进入系统初始化配置

接下来就是和树莓派一样的过程了, 镜像刷到 tf 卡然后:插电、开机、午安大电牛,轻松点亮。

但是我应该先把 setup-alpine 项目和 aports 的 bootstrap 过程逻辑完整过一遍。 不然出的镜像太不负责任(心里没底),这也是我下个月的主要目标。

donation

找到了 nixd

life

早睡早起大失败,下月再战。

2026-02

wayland

启动台、Bar、Switcher 这三个可以整合一起到 Bar 中,实现类似 CtrlP 的效果。 大概可以等 wless 完成后再考虑,其中 fzf 的模糊匹配功能最好独立为库。

- https://github.com/junegunn/fzf

- https://github.com/helix-editor/nucleo

- https://codeberg.org/adnano/wmenu

本月尝试对 Foot 在 Cage 下的异常底部间隙进行分析,当前正在看 wlroots 的 Scene 接口,应该下个月就能基本完成理解。

happy new year

新年快乐!谢谢大家照顾。还在网上领到了不少红包。

overthinkin

之前做的提权小工具 soda 改名为 keyi (可以)并完全重置。 世俗的视角看,keyi 存在很多问题:

- 无密码验证,只要在 wheel 组的用户都能直接提权

- 编辑器命令注入,修改 EDITOR 就能多编辑额外的文件

但是这不影响 keyi 项目本身,权限设计如此,编辑器也是跑在普通用户。

alpine

纯摸鱼基本没有参与活动,有点讨厌 Vibe 参与的 Rust 项目,不想给 LLM 擦屁股。

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/96772

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97066

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97096

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97101

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97123

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97283

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97783

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/97875

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/98138

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/98156

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/98157

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/98158

其中 pref、py-spy、television 三个项目测试都炸了一堆,后面看看怎么修(哭)。

donation

作者是我微信好友,他另一个叫做《程序员做饭指南》的项目可能更出名一点。

有些事情快忘了为什么不做了,因此必须做一个 checklist 持续观察依赖关系。

radxa

现在手里有 q6a 和 o6n,计划做点镜像

- https://gitlab.alpinelinux.org/alpine/alpine-conf

- https://gitlab.alpinelinux.org/alpine/mkinitfs

- https://gitlab.alpinelinux.org/alpine/aports/-/tree/master/scripts

- https://docs.kernel.org/admin-guide/efi-stub.html

- https://docs.kernel.org/admin-guide/initrd.html

- https://git.alpinelinux.org/aports/tree/main/linux-lts?h=master

- https://docs.radxa.com/dragon/q6a

bushi

- bushi-index

- bushi-web

- bushi-hook(scan)

wless

- foot resize debug

- fork wmenu

- sway scene

- rename

2025 Summary

2025 年可能是过去若干年中变动最大的一年

乙巳春节

这年的春节是早早的 1 月 29 日,不过我 25 日顺利到家。

路程的上半段是到芜湖的高铁,高铁站亮堂堂很是漂亮,但大厅里鲜有二三十岁的年轻人, 问了本地友人说是刚好错过年轻人与学生的两波高峰,现在人少少看起来年龄稍微偏老。

下半段再坐绿皮车的卧铺到家。本科头两年我也经常坐绿皮卧铺上学,但这一班格外破旧,可能平时闲置春节上工。 即便如此,还是有很多人买不到票——在车上的人也没票,往往只买一站,然后挤一挤去 6 号硬座车厢补票; 这是相当不容易,车厢挤满了想补票的人群,大过年上班的乘务员有点压力, 但大家都是赶着回家的人,带着整整一年的期望与等待,倒也不会有什么治安问题。

我对放假很恍惚,无论是暑假寒假、还是普普通通的周末,这种恍惚感不知道从何时起。 小时候我不擅长语文,背诵是浪费时间怎么都记不住,40 分钟的语文早读一段话都难背, 写作更是周末一个下午都写不好(不知道现在的我有无达到初中同学平均水平), 儿时不知道什么叫抑郁,对着方格纸总是发呆,等熬完了作文、睡觉上学又是周而复始。

作业完成了也不知道干什么,这个问题影响了我的前二三十年。 小学二年级在我完成作业后,家长额外要求把语文笔记进行背诵——那我为什么要专心完成作业呢? 春晚没怎么看,但是那首歌还挺好,“小时不识月,呼作白玉盘”, 还好跨过时间,我和小时候看到了同一个月亮,真好,时间也可以折叠。

以上这段是春节时写的,不忍心删掉就复制了过来

上班

不劳动的人会逐渐废掉,所以劳动是人的基本权利。 劳动收获就好像有些公司的内账和外账,身临其中才知道内账记了什么。

来读研的主要目的是之前觉得自己能力不足,需要继续学习(无论学什么)。 还好我在读研这三年发现了有意思的事情,闲暇时间除了内耗都扑在了上面。

感谢导师感谢学校感谢课题组同门不杀之恩,赶在最后几个月大小论文顺利达标。

顺利入职深之度也就是 deepin 家,希望明年可以更适应工作环境,搞点新东西。

自己已经做了好几年的小项目「窗管」、「GitWeb」在 2025 年都有了大进展。 虽然外表看起来还是都不能用,但是预计 2026 年都没什么问题了!

Alpine Linux

这年基本算成为了一名普通打包工,2025 年打包提交共 166 个,其他提交不到 10 个。 希望明年能维持在 150-200 个提交之间。这年挖了不少大坑没填,比如 Python 等。

不知道能不能把搜包网站升级一下(说是升级,要改基本就是重写了)

- 跨发行版搜索软件包

- 软件包内文件路径搜索

- 正规搜索筛选条件

- 增加信息统计面板

由于自己的窗管和 GitWeb 都没做完,有部分计划需要 2026 年年底再看了。

2025-10

Alpine Linux

- https://gitlab.alpinelinux.org/alpine/aports/-/issues/17499

- https://gitlab.alpinelinux.org/alpine/aports/-/issues/17605

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/90725

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91364

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91610

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91611

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91612

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91614

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91664

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91692

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91928

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91929

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/92020

原计划在国庆假期把 Python 相关的包努力做一做,setup.py install 相关函数将要在

月底废弃,但是经过努力决定开摆,原因有下:

- 当前在不测试的情况下完全无法分辨是否依赖有缺失

- 很多上游不着急,构建系统的切换还是上游做合适

- 缺少项目经验,不明白 nox、pytest、uv 等的工作原理

- 使用的 py3-gpep517 脚本协议错误,提了修改没人管

这个月 pmos 的人引入了 systemd 子包功能到 abuild,也算是对社区的又一次冲击(摊手), 不知道 WHLUG 能不能做个闪电分享讲讲这些事:

- https://gitlab.alpinelinux.org/alpine/abuild/-/merge_requests/272

- https://gitlab.alpinelinux.org/alpine/abuild/-/merge_requests/433

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/91516

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/84539

- https://gitlab.alpinelinux.org/alpine/aports/-/merge_requests/85504

- https://github.com/systemd/mkosi/pull/3781

Wless & Wayland

隔了一整个 8 月和 9 月没写,之前写的代码有点看不懂了,于是也重新看。

- 在 sway 中 layer-shell 是挂在 output 下,渲染时 reparent 到 server

- 在 dwl 中 border 是挂在 client 下,对于我的场景应该适合挂在 output 里

wlr_scene_node_set_size需要考虑到 pending 状态(tinywl 的 resize 没考虑)

之前拆多文件是为了使用 AI 写代码理解方便,但是体验了 VSCode + cline + DeepSeek, 小几千行的情况下,单文件对 AI 和对我的原生 Vim 来说都更方便,我就改回去了。

协议 wlr output management 是为了客户端 Read 或者 Write 服务端的显示器设置

-

zwlr_output_manager_v1- request

create_configuration>>zwlr_output_configuration_v1 - request

stop - event

head>>zwlr_output_head_v1只读的广播,没什么逻辑 - event

done - event

finished

- request

-

zwlr_output_configuration_v1- request

enable_head>>zwlr_output_configuration_head_v1+zwlr_output_head_v1 - request

disable_head>>zwlr_output_head_v1 - request

apply - request

test - request

destroy

- request

-

zwlr_output_configuration_head_v1- request

set_{mode,position,etc.}

- request

-

https://wayland.app/protocols/wlr-output-management-unstable-v1

10 月用两个周末的时间完全重写了之前的配置文件(主要是快捷键)的逻辑,

大幅度依赖 getopt、getsubopt、wordexp 这三个标准库函数。

修改之后实现了两个目标:

- 决定把部分复杂功能从 WM 本体中丢出去,降低配置的复杂度

- 命令行与配置文件使用同一套解析函数

认真学习了 wlr_output_layout_output 相关内容(并不认真):

显示器的 enable 在非原生后端时可能会修改,但是如果 output 不在整个 layout 中,

我们也应该认为这个显示器是 disable 的。应用到具体场景就是用户的笔记本显示器熄屏,

此时物理上显示器连接,但是显示器没有真正投入使用,用户可能扣着盖子用外接屏幕。

Bushi & Git

重新审视了这个项目的整体架构,思考下一步真的要做什么。 项目已有的“祖先跳表”设计令人兴奋,但是内部数据的生成还是依赖 git-fast-export, 这不优雅:

- 很难控制 git-cli 本体的内存占用,据测算需要 800 Mb(使用 aports.git 仓库)

- 命令行输出的解析是用的手抠字符串,虽然能跑但相当原始

- 初始化更新和后续更新可能逻辑不一致,写两套函数无法接受

所以最好这里再细节一点。

先尝试的是字符串解析,尝试使用 nom 但阅读文档后发现,这个库必须先把字符串读取为

&str,这就很不合适,因为管道重定向是 Stream 流:数据量大、输出时间长、

不保证字符编码。目前也没有什么其他库做这件事很合适,所以搁置。

用原版 git-cli 和 libgit2 各做 1000 次提交差异对比,发现原版速度就是快一个数量级

export GIT_PAGER=cat

git diff --no-color --name-only "$commit_old" "$commit_new"

看了会儿 libgit2 的源码思考为什么如此慢。发现它读取 object-tree 这里可以改一下,

用 data 的 size 除以 oid_t + mode + 6,然后拿这个数值去初始化数组,

避免很多次 realloc。修改后对比测试,略有提升,效果微乎其微,平均百万次读取超大

object-tree 调用提升 10s(口算)。

- https://github.com/libgit2/libgit2/blob/58d9363f02f1fa39e46d49b604f27008e75b72f2/src/libgit2/tree.c#L405

- https://linux.die.net/man/3/realloc

- https://en.cppreference.com/w/c/memory/realloc

读取有 object 后的 diff 运算没有可以优化的地方,就是简单的双指针单向遍历。

所以还没什么其他加速思路。

从 git-sizer 程序的解析结果看,把仓库中所有的 object-tree 事先解析并塞到 SQLite 的方法会导致程序体积占用很大,预计有 20 倍的膨胀,所以不可取。理想预期:

- 【内存占用小】全程不超过 200 Mb,而且缓存大小可控

- 【硬盘占用小】因为必须保留原生 git-objects 做兼容,所以尽可能产物小于同期 fossil

- 【CPU 消耗低】初始化不作要求,查询时单线程可运行

- 【解析时间短】初始化时间低于 git-fast-export 耗时的三倍,查询时间低于 git-cli

下一步计划:当前的性能瓶颈有两个,object-tree 的 read 和 diff,它们被广泛压缩在 packfile 中,不仅 IO 紧张而且 CPU 紧张。但是逆转过来想,压缩本身也是一种信息? 可能需要写一点优化后的读取方法,在读取时抓取更多信息。

备用计划:手动封装 git

- 找个支持流式解析库,优化现在的 fast-import

- 魔改 fast-export 输出 json,然后接 serde::json

- 封装原版 git-diff-stat 用 nom

QT

发现一个 Bug,右键弹出菜单中,分隔线上的点击事件无效但会导致弹出菜单消失。 使用 AI 写了个复现小 demo,提交问题到了 QT 上游。

# 感谢子冲帮忙修复 LSP 爆红

sudo apt install libstdc++-13-dev

不知道下一步会不会学习 QT 做点小工具。

论文

导师喊我改论文,这让我非常难过,尽管我知道这件事情只要完成就再也不会有烦恼了。 但我还是很难过,无法诉说的压力和恐惧,让我没有失去了对生活 60% 的注意力和快乐。 有以下几个方面需要改:

- 标点符号、文字、句子之间的连贯性

- 图表、公式、大小写

好像没了。我尽量去做吧。祝我开心。

Vim

学到了 Vim 自带的 grep 命令,非常好用,再也不需要终端里查询复制到 Vim 中再打开了。

现在是接入了 ripgrep 日常使用,配置文件略微修改:

if executable("rg")

set grepprg=rg\ --vimgrep\ --smart-case

set grepformat+=%f:%l:%c:%m

endif

把之前在 Vim 上修的小补丁 cherry-pick 到了 NeoVim 上

- https://github.com/vim/vim/commit/ce4f9d2a1016ade19fa07c5b66e58eb084719192

- https://github.com/neovim/neovim/pull/36221

Misc

博客 or 主页

修好了个人主页,去掉万年不更新的 Hugo 放了个简单的 Html 单文件,CSS 是从之前的 hugo-rss-only 仓库薅来的,设计风格来自 Nginx 默认页面。

计划在以后的 hash 按照月为单位更新日志,有其他长短文字按照内容分类,也放这里。

FetchSrc

做了一个用于下载、缓存、解压源码的 rust 小工具 fetchsrc,我的 Option 和错误处理 经验还是太匮乏了,这里写的很吃力(和 shell 差不多吃力了!)。 后面有空找个开源项目,跟踪一段时间学习错误处理。

LSP

clangd 原来默认也会搜索 build/compile_commands.json,再也不抱怨 LSP 不干活了,

之前全靠软链接和 .clangd 配置文件苟活。

SSH

终于(又一次)理解了端口转发的方向

ssh [-L|-R] [FROM_IP:]FROM_PORT:DESTINATION:DESTINATION_PORT [USER@]SSH_SERVER

对于 -L 本地端口转发来说,流量从本地端口进入,转发到 DESTINATION,所以是 LOCAL

1024

本来想搭配“麒麟”这首歌做个混剪小视频,但是和 xingji 交流后发现代码提交截图 不适合做素材,远远不如画画、徒步等,所以还是算了。

Donations

这次选择了 asciinema 项目,恰好新版本发布。

捐款上也有一些小想法:

- 参与代码贡献的项目不捐:出力不出钱,比如 Alpine Linux

- 账面还有很多钱的不捐:钱不能解决这种维护问题,比如 libgit2

- 没用过 or 不好用的不捐:特指希望倒闭的 matrix

没事可以去 https://opencollective.com/search 逛逛,想想以后自己的项目怎么搞钱

如果 11 月没想好给谁就去订阅一下 LWN,或者给服务器加点钱什么的。

2025-11

wless

本月主要关注client的resize和output的frame事件之间的关系,相关参考内容有:

- https://github.com/DreamMaoMao/mangowc/issues/293

- https://github.com/swaywm/sway/blob/055be4ec35eec4eaaf066a18ccbf5132ebed0694/sway/desktop/output.c#L374

- https://github.com/swaywm/sway/pull/2072

- https://wayland.app/protocols/xdg-shell#xdg_surface:request:ack_configure

问题的矛盾在于窗口的大小和窗口的位置改变不同步,如果我想让窗口进入全屏:

- WM立即将窗口的左上顶点移动对齐到左上角

- WM请求窗口改变大小,此时窗口占据了1/4屏幕(举例)

- 窗口响应WM,变为全屏,此时窗口全面覆盖

窗口的位置是WM没有延迟随意操作的,而窗口的大小需要客户端自己去响应,两者几乎不会在同一帧完成。 在这个时间裂缝里,窗口从1/4到全屏不可避免的闪了一次。 还没想好怎么处理,可能需要卡住显示器,或者等窗口响应的pre-commit里再去改变位置。

12月应该没时间看,可能又要等到明年了。

bushi

nom似乎可以对stream进行解析,之前可能没注意到? 研究了一番放弃了这个灵车的想法!(见后)

从i5换到了n5105,耗时差不多是两倍:

git-log–stat 5m16s

git log --oneline --stat > /dev/null

git-fast-export 3m45s

git fast-export --no-data --fake-missing-tagger --signed-tags=strip --all > /dev/null

据研究packfile包含的压缩信息确实可用(好像废话,不然git是怎么把20G压缩到600M的)

git verfy-pack -v .git/objects/pack/pack-*.idx

但是没有稳定性保证,压缩的基准与提交顺序有关系但不保证, 高概率出现ABCD等多个tree都基于同一个base差值压缩的情况。 因此当前决定还是不做这个了, 我们还是愉快的攀附在git二进制文件上,对输出进行解析吧!

- 扫描所有refs,存储到数据库

- 从refs中的一个开始,遍历commit到存在时停止

- 重新于root索引commits

- 基于git-log拿到changed-path,文件修改存数据库

- 重复2直到完成所有

- 从上到下构建祖先跳表,存另一个表

想了两周要不要每个仓库分一个SQLite数据库

- 更方便管理(主要原因)

- 可能剩下一个复合主键的空间(但是sha256sum对主键来说还是太长了)

但是缺少能够管理256-2048个独立SQLite数据库的现有库(对CGI来说这不是问题), 所以还是保持现状吧。

记录下体积大小的对比,所以不压缩真顶不住。

$ du -sh loose-aports/

28.7G loose-aports/

$ du -sh aports/

790.1M aports/

重新设计了bushi的架构:

- 把之前头疼的配置问题拆到第一部分(之前网络端口设置和仓库设置混在一起感觉别扭)

- 为了避免插入中String -> CString -> SQLite的多次复制问题,索引更新部分换C了

- 网站托管部分还是上Rust的Tokio生态,此时SQLite只读,所以可以大幅度开启连接池加速

bushi-hook(-)

collect git repositories’ path and rediect them to next program’s stdin

cron, sleep or triggered by something else

copy bushi.db and send signal to bushi-web, it will refresh connection

bushi-index(C)

$ bushi-index [-vh] [-c] [-t stage.db] repo ...

$ bushi-index [-vh] [-c] [-t stage.db] -

-c cleanup unused repositories

-t target sqlite database

- read from stdin

repo GIT_DIR

read path from stdin and update index in stage.db

bushi-web(Rust)

$ bushi-web [-vh] [--index bushi.db] [--host HOST] [--port PORT]

open bushi.db with read only option, host web

firefox & dde

火狐在dde上一直有缩放问题,主要症状是系统设置缩放(非1)后,火狐界面异常大。 在论坛上有很多反馈:

- Firefox火狐浏览器界面异常变大原因-论坛-深度科技

- V25和火狐浏览器有点冲突-论坛-深度科技

- deepin 25 火狐浏览器莫名的分辨率变大-论坛-深度科技

- 火狐浏览器firefox高分屏设置无效-论坛-深度科技